Da li ste u potrazi za alatima koji će unaprediti vaš SEO rejting, vidljivost i konverzije? Za ostvarenje tih ciljeva, neophodan vam je alat za indeksiranje web stranica. Web skener, ili „crawler“, je kompjuterski program koji vrši pretragu interneta. Web pauci, softveri za ekstrakciju web podataka i programi za sakupljanje informacija sa web sajtova su primeri tehnologija koje se koriste za pretraživanje interneta. Takođe, često se nazivaju botovima ili paucima. Danas ćemo razmotriti nekoliko besplatnih alata za web indeksiranje koje možete preuzeti.

25 Izvanrednih Besplatnih Alata za Web Indeksiranje

Alati za web indeksiranje nude bogatstvo informacija za prikupljanje i analizu podataka. Njihova osnovna svrha je indeksiranje web stranica na internetu. Ovi alati mogu detektovati pokvarene linkove, duplirani sadržaj, nedostajuće naslove stranica i identifikovati ozbiljne SEO probleme. Čišćenje podataka sa mreže može biti od velike koristi za vaše poslovanje na više načina.

- Nekoliko aplikacija za web indeksiranje može precizno popisati podatke sa bilo koje URL adrese web stranice.

- Ovi programi vam pomažu da poboljšate strukturu vašeg web sajta, omogućavajući pretraživačima da ga lakše razumeju i tako poboljšaju vašu poziciju u rezultatima pretrage.

Na listi koju smo sastavili, predstavljamo pregled najboljih besplatnih alata za web indeksiranje, ističući njihove karakteristike i troškove. Na listi se nalaze i aplikacije koje se plaćaju.

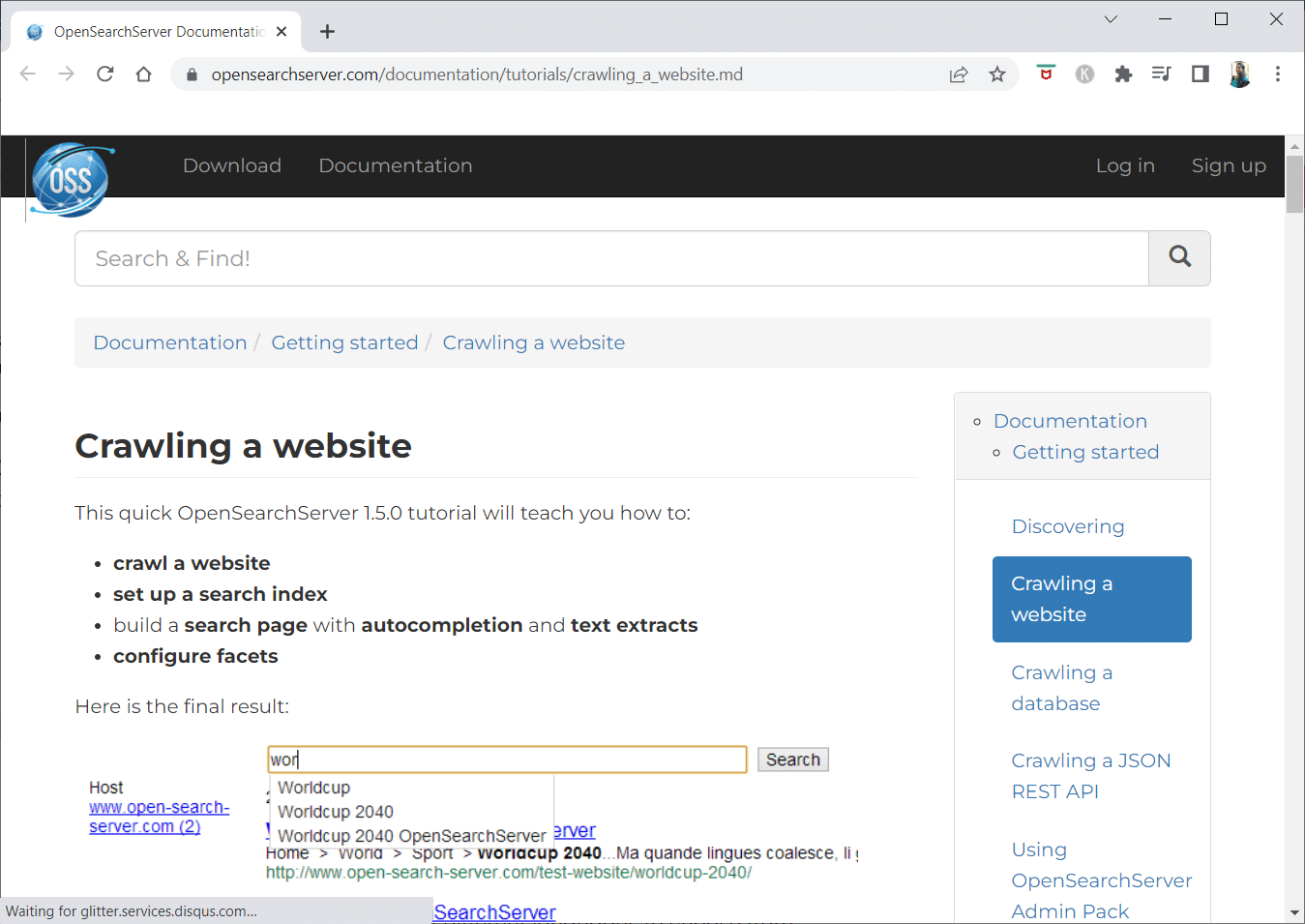

1. Open Search Server

OpenSearchServer je besplatan pretraživač web sadržaja i jedan je od najcenjenijih na internetu. Predstavlja jednu od najboljih dostupnih alternativa.

- Radi se o potpuno integrisanom rešenju.

- Open Search Server je web pretraživač i alat za pretraživanje koji je besplatan i otvorenog koda.

- To je isplativo rešenje koje se jednostavno primenjuje.

- Sadrži sveobuhvatan set mogućnosti pretraživanja i omogućava vam da kreirate sopstvenu strategiju indeksiranja.

- Pokretači mogu indeksirati skoro sve.

- Možete birati između pretraživanja punog teksta, logičkih i fonetskih pretraga.

- Dostupno je 17 različitih jezika.

- Automatske klasifikacije su integrisane.

- Možete kreirati raspored za česte događaje.

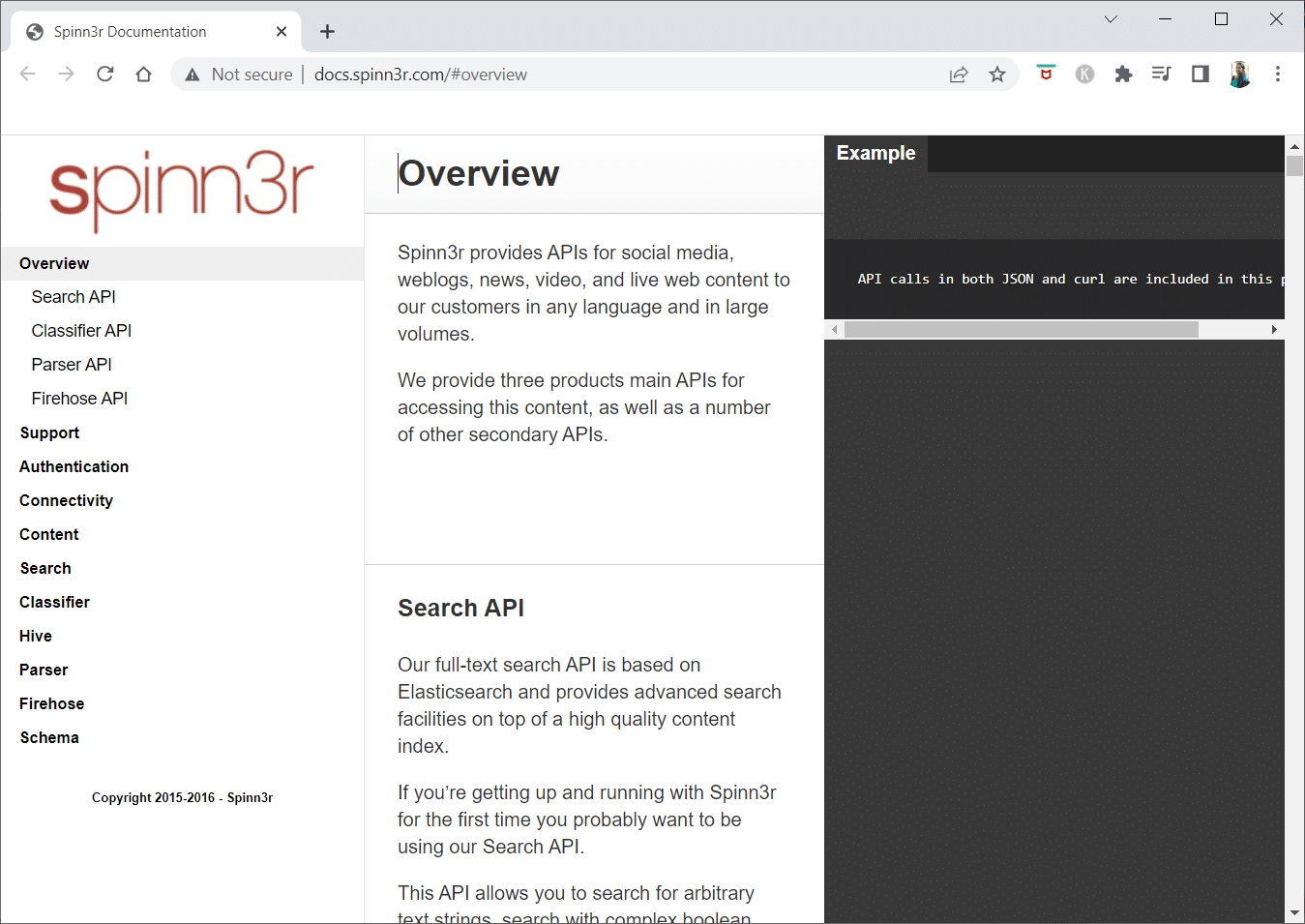

2. Spinn3r

Spinn3r program za indeksiranje web sadržaja omogućava vam da efikasno izdvajate sadržaj sa blogova, vesti, društvenih mreža, RSS feedova i ATOM feedova.

- Dolazi sa API-jem visokih performansi koji obrađuje 95% posla indeksiranja.

- Napredna zaštita od neželjene pošte je uključena u ovu aplikaciju za indeksiranje weba, koja uklanja spam i neprikladnu upotrebu jezika, poboljšavajući bezbednost podataka.

- Web skreper neprestano pretražuje internet u potrazi za ažuriranjima iz različitih izvora kako bi vam dostavio sadržaj u realnom vremenu.

- Indeksira sadržaj na sličan način kao Google, a izvučeni podaci se čuvaju kao JSON datoteke.

- Parser API vam omogućava da brzo analizirate i manipulišete informacijama za bilo koje web URL adrese.

- Firehose API je dizajniran za masovan pristup ogromnim količinama podataka.

-

Jednostavni HTTP headeri se koriste za autentifikaciju svih Spinn3r API-ja.

- Ovo je alatka za web indeksiranje koju možete besplatno preuzeti.

- API za klasifikator omogućava programerima da prenose tekst (ili URL-ove) koji će biti označeni našom tehnologijom mašinskog učenja.

3. Import.io

Import.io vam omogućava da u kratkom vremenskom periodu, izvučete milione web stranica i kreirate više od 1000 API-ja koji odgovaraju vašim potrebama bez potrebe za pisanjem koda.

- Sada se njime može upravljati programski, a podaci se mogu automatski preuzimati.

- Izvucite podatke sa velikog broja stranica jednim klikom.

- Može automatski prepoznati liste sa stranica ili možete ručno kliknuti na dugme „sledeća stranica“.

- Možete ugraditi online podatke u svoju aplikaciju ili web sajt sa samo nekoliko klikova.

- Kreirajte sve potrebne URL-ove u sekundi koristeći različite obrasce, kao što su brojevi stranica i nazivi kategorija.

- Import.io nudi demonstraciju procesa izvlačenja podataka sa stranice. Jednostavno odaberite kolonu iz vašeg skupa podataka i pokažite na neki element na stranici koji vam je interesantan.

- Možete zatražiti ponudu na njihovoj web stranici.

- Linkovi na stranicama sa listama vode do detaljnih stranica koje sadrže dodatne informacije.

- Možete koristiti Import.io da preuzmete sve podatke sa detaljnih stranica odjednom.

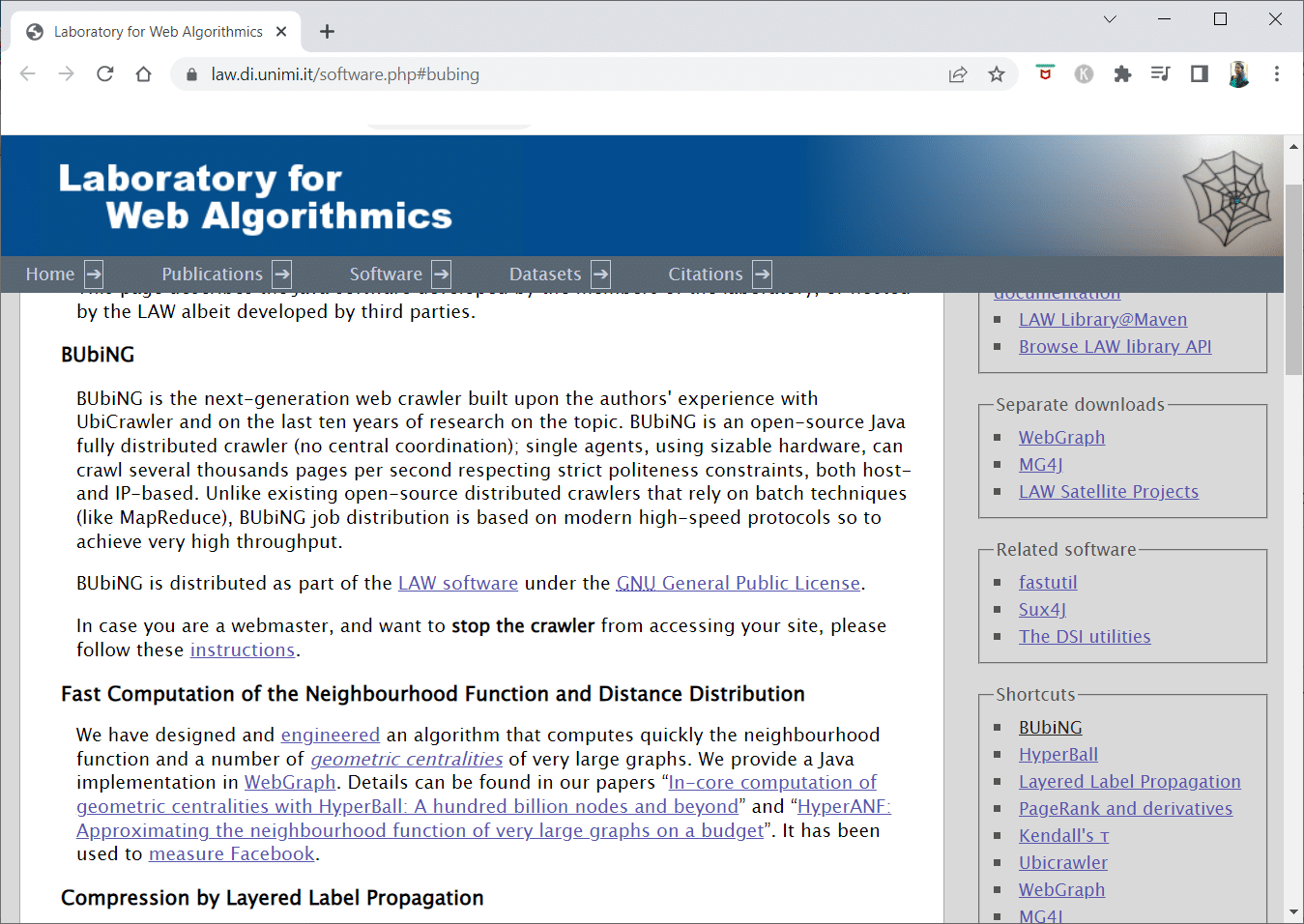

4. BUBiNG

BUBiNG, alat za web indeksiranje nove generacije, predstavlja vrhunac autorskog iskustva sa UbiCrawler-om i desetogodišnjeg istraživanja u ovoj oblasti.

- Jedan agent može indeksirati hiljade stranica u sekundi, poštujući stroge standarde pristojnosti, kako na hostu tako i na IP adresi.

- Njegova distribucija poslova se zasniva na modernim protokolima velike brzine za isporuku veoma velikog protoka, za razliku od ranijih distribuiranih pretraživača otvorenog koda koji se oslanjaju na batch tehnike.

- Koristi otisak prsta ogoljene stranice za otkrivanje gotovo dupliranih sadržaja.

- BUBiNG je potpuno distribuiran Java pretraživač otvorenog koda.

- Ima visok stepen paralelizacije.

- Veliki broj ljudi koristi ovaj proizvod.

- Brz je.

- Omogućava indeksiranje velikih razmera.

5. GNU Wget

GNU Wget je besplatan alat za web indeksiranje dostupan za besplatno preuzimanje. To je softver otvorenog koda napisan u C-u koji vam omogućava da preuzimate datoteke putem HTTP, HTTPS, FTP i FTPS protokola.

- Jedna od najizrazitijih karakteristika ove aplikacije je sposobnost kreiranja datoteka sa porukama zasnovanim na NLS-u na različitim jezicima.

- Možete nastaviti preuzimanja koja su prekinuta korišćenjem REST i RANGE funkcija.

- Takođe može transformisati apsolutne linkove u preuzetim dokumentima u relativne linkove ako je to potrebno.

- Rekurzivno koristite džokere u nazivima datoteka i direktorijumima ogledala.

- Datoteke sa porukama zasnovane na NLS-u za različite jezike.

- Tokom procesa preslikavanja, vremenske oznake lokalnih datoteka se procenjuju kako bi se utvrdilo da li dokumente treba ponovo preuzeti.

6. Webhose.io

Webhose.io je fantastična aplikacija za indeksiranje web sadržaja koja vam omogućava da skenirate podatke i izdvajate ključne reči na nekoliko jezika, koristeći različite filtere koji obuhvataju širok spektar izvora.

- Arhiva takođe omogućava korisnicima da vide prethodne podatke.

- Pored toga, Webhose.io otkrića podataka za indeksiranje dostupna su na do 80 jezika.

- Sve lične informacije koje su kompromitovane mogu se naći na jednom mestu.

- Istražite „dark web“ i aplikacije za razmenu poruka o sajber pretnjama.

-

XML, JSON i RSS formati su takođe dostupni za kopirane podatke.

- Možete zatražiti ponudu na njihovoj web stranici.

- Korisnici mogu jednostavno indeksirati i pretraživati strukturirane podatke na Webhose.io.

- Može da prati i analizira medijske kuće na svim jezicima.

- Moguće je pratiti diskusije na oglasnim tablama i forumima.

- Omogućava vam da pratite ključne objave na blogu sa celog weba.

7. Norconex

Norconex je odličan resurs za kompanije koje traže aplikaciju za web indeksiranje otvorenog koda.

- Ovaj kolektor sa svim funkcijama se može koristiti ili integrisati u vaš program.

- Takođe može da preuzme istaknutu sliku stranice.

- Norconex vam daje mogućnost da indeksirate sadržaj bilo koje web stranice.

- Moguće je koristiti bilo koji operativni sistem.

- Ovaj softver za web indeksiranje može popisati milione stranica na jednom serveru prosečnog kapaciteta.

- Takođe uključuje set alata za modifikaciju sadržaja i metapodataka.

- Pribavite metapodatke za dokumente na kojima trenutno radite.

-

Podržane su stranice koje se prikazuju u JavaScript-u.

- Omogućava otkrivanje više jezika.

- Pruža pomoć pri prevođenju.

- Brzina kojom pretražujete web sadržaj može se menjati.

- Identifikuju se dokumenti koji su izmenjeni ili uklonjeni.

- Ovo je potpuno besplatan program za indeksiranje weba.

8. Dexi.io

Dexi.io je web aplikacija za indeksiranje zasnovana na pretraživaču koja vam omogućava da prikupite informacije sa bilo kog web sajta.

-

Ekstraktori, „crawleri“ i cevi su tri tipa robota koje možete koristiti u operaciji sakupljanja podataka.

- Kretanje na tržištu se predviđa korišćenjem Delta izveštaja.

- Vaši prikupljeni podaci će biti sačuvani dve nedelje na serverima Dexi.io pre arhiviranja, ili možete odmah izvesti izvučene podatke kao JSON ili CSV datoteke.

- Možete dobiti ponudu na njihovoj web stranici.

- Nude se profesionalne usluge, kao što su osiguranje kvaliteta i tekuće održavanje.

- Nudi komercijalne usluge koje će vam pomoći da ispunite svoje potrebe za podacima u realnom vremenu.

- Moguće je pratiti zalihe i cene za neograničen broj SKU/proizvoda.

- Omogućava vam da integrišete podatke koristeći kontrolne table uživo i potpunu analitiku proizvoda.

- Pomaže vam da pripremite i analizirate organizovane i spremne podatke o proizvodu zasnovane na webu.

9. Zyte

Zyte je alatka za ekstrakciju podataka zasnovana na cloudu koja pomaže hiljadama programera da pronađu ključne informacije. Takođe, to je jedna od najboljih besplatnih aplikacija za indeksiranje weba.

- Korisnici mogu da sakupljaju podatke sa web stranica koristeći njihovu aplikaciju za vizuelno sakupljanje podataka otvorenog koda, bez ikakvog znanja programiranja.

-

Crawler, kompleksan proksi rotator koji koristi Zyte, omogućava korisnicima da lako indeksiraju velike sajtove ili sajtove zaštićene botovima, dok istovremeno izbegavaju kontramere botova.

- Vaše online informacije se isporučuju po rasporedu i dosledno. Dakle, umesto da upravljate proxy serverima, možete se fokusirati na dobijanje podataka.

- Zahvaljujući mogućnosti pametnog pretraživača i renderovanja, anti-botovi koji ciljaju sloj pretraživača se sada mogu lako kontrolisati.

- Na njihovoj web stranici možete zatražiti ponudu.

- Korisnici mogu da indeksiraju sa različitih IP adresa i regiona koristeći jednostavan HTTP API, eliminišući potrebu za održavanjem proksija.

- Pomaže vam da zaradite novac, istovremeno štedeći vreme dobijanjem informacija koje su vam potrebne.

- Omogućava vam da izvučete web podatke u velikom obimu, uz uštedu vremena na programiranju i održavanju web paukova.

10. Apache Nutch

Apache Nutch je nesumnjivo na vrhu liste za najveću aplikaciju za web indeksiranje otvorenog koda.

- Može raditi na jednoj mašini. Međutim, najbolje radi na Hadoop klasteru.

- Za autentifikaciju se koristi NTLM protokol.

- Ima distribuirani sistem datoteka (preko Hadoop-a).

- To je poznati softverski projekat za ekstrakciju online podataka otvorenog koda, koji je prilagodljiv i skalabilan za rudarenje podataka.

- Mnogi analitičari podataka, naučnici, programeri aplikacija i stručnjaci za rudarenje web teksta ga koriste širom sveta.

- To je rešenje za više platformi zasnovano na Java-i.

- Po podrazumevanoj vrednosti, preuzimanje i raščlanjivanje se obavljaju nezavisno.

- Podaci se mapiraju pomoću XPath-a i imenskih prostora.

- Sadrži bazu podataka grafova veza.

11. VisualScraper

VisualScraper je još jedan fantastičan web skreper bez kodiranja za izvlačenje podataka sa interneta.

- Nudi jednostavan korisnički interfejs „pokaži i klikni“.

- Takođe nudi usluge sakupljanja podataka sa weba, kao što su distribucija podataka i izrada softverskih ekstraktora.

- Prati i vaše konkurente.

- Korisnici mogu zakazati da se njihovi projekti pokreću u određeno vreme ili da se sekvenca ponavlja svakog minuta, dana, nedelje, meseca i godine pomoću VisualScraper-a.

- Jeftiniji je i efikasniji.

- Nema čak ni koda koji treba spominjati.

- Ovo je potpuno besplatan program za indeksiranje weba.

- Podaci u realnom vremenu se mogu izvući sa više web stranica i sačuvati kao CSV, XML, JSON ili SQL datoteke.

- Korisnici ga mogu koristiti za redovno izdvajanje vesti, ažuriranja i objava na forumu.

- Podaci su 100% tačni i prilagođeni.

12. WebSphinx

WebSphinx je fantastična lična besplatna aplikacija za indeksiranje web stranica koja se lako podešava i koristi.

- Dizajnirana je za sofisticirane web korisnike i Java programere koji žele automatski da skeniraju ograničen deo interneta.

- Ovo rešenje za ekstrakciju podataka na mreži uključuje biblioteku Java klasa i interaktivno programsko okruženje.

- Stranice se mogu spojiti u jedan dokument koji se može pretraživati ili štampati.

-

Izdvojite sav tekst koji odgovara datom obrascu iz niza stranica.

- Web „crawleri“ sada mogu biti napisani u Java-i zahvaljujući ovom paketu.

- Crawler Workbench i WebSPHINX biblioteka klasa su uključeni u WebSphinx.

- Crawler Workbench je grafički korisnički interfejs koji vam omogućava da prilagodite i upravljate web pretraživačem.

- Od grupe web stranica može se napraviti grafikon.

- Sačuvajte stranice na lokalnom disku za čitanje van mreže.

13. OutWit Hub

OutWit Hub platforma se sastoji od jezgra sa opsežnom bibliotekom mogućnosti prepoznavanja i ekstrakcije podataka. Na toj osnovi se može kreirati beskonačan broj različitih aplikacija, od kojih svaka koristi karakteristike jezgra.

- Ova aplikacija za web indeksiranje može skenirati sajtove i sačuvati podatke koje pronađe na pristupačan način.

- To je višenamenski alat koji nudi širok spektar funkcija za ispunjavanje različitih zahteva.

- Hub postoji već duže vreme.

- Razvio se u korisnu i raznovrsnu platformu za ne-tehničke korisnike i IT profesionalce koji znaju kako da kodiraju, ali prepoznaju da PHP nije uvek idealna opcija za izdvajanje podataka.

- OutWit Hub pruža jedinstven interfejs za prikupljanje manjih ili velikih količina podataka, u zavisnosti od vaših potreba.

- Omogućava vam da izvučete bilo koju web stranicu direktno iz pretraživača i kreirate automatizovane agente koji preuzimaju podatke i pripremaju ih prema vašim zahtevima.

- Možete zatražiti ponudu na njihovoj web stranici.

14. Scrapy

Scrapy je Python online framework za sakupljanje podataka sa weba, koji se koristi za kreiranje skalabilnih web pretraživača.

- To je kompletan framework za indeksiranje weba, koji upravlja svim karakteristikama koje otežavaju kreiranje web pretraživača, kao što su proksi posredovanje i pitanja za postavljanje upita.

- Možete napisati pravila za izdvajanje podataka, a zatim pustiti Scrapy da se pobrine za ostalo.

- Lako je dodati nove funkcije bez modifikacije jezgra, s obzirom da je tako dizajnirano.

- To je program zasnovan na Python-u koji radi na Linux, Windows, Mac OS X i BSD sistemima.

- Ovo je potpuno besplatan program.

- Njegova biblioteka pruža programerima strukturu spremnu za korišćenje za prilagođavanje web pretraživača i izvlačenje podataka sa weba u velikom obimu.

15. Mozenda

Mozenda je takođe odlična besplatna aplikacija za indeksiranje weba. Reč je o poslovno orijentisanom programu za web scraping zasnovanom na cloudu, koji se može samostalno koristiti. Mozenda ima više od 7 milijardi pregledanih stranica i ima korporativne klijente širom sveta.

- Tehnologija web scraping-a kompanije Mozenda eliminiše potrebu za skriptama i angažovanjem inženjera.

- Ubrzava prikupljanje podataka do pet puta.

- Možete sakupljati tekst, datoteke, slike i PDF informacije sa web sajtova pomoću Mozendine opcije „pokaži i klikni“.

- Organizovanjem datoteka sa podacima možete ih pripremiti za objavljivanje.

- Možete izvoziti direktno u TSV, CSV, XML, XLSX ili JSON koristeći Mozendin API.

- Možete koristiti Mozendin sofisticirani „Data Wrangling“ za organizovanje svojih informacija, kako biste mogli donositi važne odluke.

- Možete koristiti jednu od Mozendinih partnerskih platformi za integraciju podataka ili uspostaviti prilagođene integracije podataka u više platformi.

16. Cyotek WebCopy

Cyotek WebCopy je besplatan alat za web indeksiranje koji vam omogućava da automatski preuzmete sadržaj web sajta na svoj lokalni uređaj.

- Sadržaj odabrane web stranice će biti skeniran i preuzet.

- Možete odabrati koje delove web sajta želite da klonirate i kako da koristite njegovu složenu strukturu.

- Nova lokalna ruta će preusmeriti linkove ka resursima web sajta, kao što su stilovi, slike i druge stranice.

- Pogledaće HTML tagove web sajta i pokušaće da pronađe sve povezane resurse, kao što su druge web lokacije, fotografije, video snimci, preuzimanja datoteka i slično.

- Može da indeksira web sajt i preuzme sve što vidi da bi napravio prihvatljivu kopiju originala.

17. Common Crawl

Common Crawl je namenjen svima koji su zainteresovani za istraživanje i analizu podataka kako bi stekli korisne uvide.

- To je neprofitna organizacija 501(c)(3) koja se oslanja na donacije kako bi pravilno vodila svoje operacije.

- Svako ko želi da koristi Common Crawl to može učiniti bez trošenja novca ili izazivanja problema.

- Common Crawl je korpus koji se može koristiti za podučavanje, istraživanje i analizu.

- Trebalo bi da pročitate članke ako nemate nikakve tehničke veštine da saznate o izvanrednim otkrićima koje su drugi napravili koristeći Common Crawl podatke.

- Nastavnici mogu koristiti ove alate za podučavanje analize podataka.

18. Semrush

Semrush je aplikacija za indeksiranje web lokacija koja ispituje stranice i strukturu vaše web stranice u potrazi za tehničkim SEO problemima. Rešavanje ovih problema može vam pomoći da poboljšate rezultate pretrage.

- Ima alate za SEO, istraživanje tržišta, marketing na društvenim mrežama i oglašavanje.

- Ima korisnički interfejs prilagođen korisniku.

-

Metapodaci, HTTP/HTTPS, direktive, statusni kodovi, duplirani sadržaj, brzina odziva stranice, interno povezivanje, veličine slika, strukturirani podaci i drugi elementi će biti ispitani.

- Omogućava vam brzu i jednostavnu reviziju vaše web stranice.

- Pomaže u analizi datoteka evidencije.

- Ovaj program pruža kontrolnu tablu koja vam omogućava da lako vidite probleme sa web lokacijama.

19. Sitechecker.pro

Sitechecker.pro je još jedna izvanredna besplatna aplikacija za indeksiranje weba. To je SEO provera za web lokacije, koja vam pomaže da poboljšate svoje SEO rangiranje.

- Možete lako da vizualizujete strukturu web stranice.

- On kreira izveštaj SEO revizije na stranici, koji klijenti mogu primiti putem e-pošte.

- Ovaj alat za indeksiranje weba može da pregleda interne i eksterne linkove vaše web lokacije.

- Pomaže vam da odredite brzinu vaše web stranice.

- Takođe možete koristiti Sitechecker.pro da proverite probleme sa indeksiranjem na odredišnim stranicama.

- Pomaže vam da se odbranite od hakerskih napada.

20. WebHarvy

WebHarvy je alatka za sakupljanje podataka sa weba sa jednostavnim interfejsom „pokaži i klikni“. Dizajniran je za one koji ne znaju da kodiraju.

- Cena licence počinje od 139 dolara.

- Koristićete WebHarvy-ov ugrađeni pretraživač da učitavate web sajtove i birate podatke koji će se izvući pomoću klikova mišem.

- Može automatski da izvuče tekst, fotografije, URL adrese i e-poruke sa web lokacija i da ih sačuva u različitim formatima.

-

Proxy serveri ili VPN mogu se koristiti za pristup ciljnim web lokacijama.

- Sakupljanje podataka ne zahteva kreiranje bilo kakvog programiranja