U digitalnoj eri u kojoj živimo, količina podataka meri se terabajtima i petabajtima, a njihov rast je eksponencijalan. Postavlja se pitanje kako te obimne podatke iskoristiti i pretvoriti u korisne informacije koje mogu unaprediti dostupnost usluga?

Kvalitetni, novi i razumljivi podaci su ključni za kompanije koje žele da izgrade efikasne modele za sticanje znanja.

Upravo zbog toga, preduzeća primenjuju analitičke metode na različite načine kako bi otkrila vredne podatke.

No, odakle počinje celokupan proces? Odgovor leži u obradi podataka.

Krenimo sa objašnjenjem!

Šta je obrada podataka?

Obrada podataka predstavlja proces čišćenja, strukturiranja i transformacije sirovih podataka u formate koji olakšavaju njihovu analizu. Često se radi sa neuređenim i složenim skupovima podataka koji nisu odmah spremni za dalju obradu. Obrada podataka transformiše sirove podatke u prečišćeno, optimizovano stanje, spremno za upotrebu.

Neke od uobičajenih operacija u obradi podataka uključuju:

- Spajanje više skupova podataka u jedinstven, sveobuhvatan skup za analizu.

- Identifikovanje i rešavanje nedostajućih ili praznih vrednosti u podacima.

- Uklanjanje odstupanja i anomalija u skupovima podataka.

- Standardizacija ulaznih podataka.

Rad sa velikim skladištima podataka obično prevazilazi mogućnosti ručne obrade, stoga su automatizovane metode pripreme podataka neophodne za postizanje preciznijih i kvalitetnijih rezultata.

Ciljevi obrade podataka

Pored primarnog cilja pripreme podataka za analizu, ostali važni ciljevi obrade podataka uključuju:

- Generisanje relevantnih i novih podataka iz neuređenih podataka, što je osnova za donošenje boljih poslovnih odluka.

- Standardizacija sirovih podataka u formate koje sistemi za obradu velikih podataka mogu efikasno da koriste.

- Smanjenje vremena koje analitičari podataka provode u kreiranju modela, zahvaljujući prezentaciji čistih i organizovanih podataka.

- Osiguranje doslednosti, potpunosti, upotrebljivosti i bezbednosti svakog skupa podataka koji se koristi ili skladišti u sistemima.

Uobičajeni pristupi obradi podataka

Otkrivanje

Pre nego što počnu sa pripremama podataka, stručnjaci moraju razumeti kako su podaci pohranjeni, njihovu veličinu, sadržane zapise, formate kodiranja, kao i druge atribute koji opisuju svaki skup podataka.

Strukturiranje

Ovaj korak podrazumeva organizaciju podataka u formate koji su laki za upotrebu. Siromavim podacima može biti potrebno strukturiranje kolona, broja redova i drugih atributa radi lakše analize.

Čišćenje

Strukturirani podaci moraju biti očišćeni od grešaka i svega što može iskriviti informacije. Čišćenje podrazumeva uklanjanje dupliranih unosa, brisanje praznih ćelija i vrednosti koje odskaču, standardizaciju unosa, preimenovanje zbunjujućih atributa i drugo.

Obogaćivanje

Nakon strukturiranja i čišćenja, potrebno je proceniti korisnost podataka i dopuniti ih vrednostima iz drugih skupova podataka kako bi se postigao željeni kvalitet.

Validacija

Validacija uključuje iterativne programske aspekte koji naglašavaju kvalitet podataka, njihovu doslednost, upotrebljivost i bezbednost. Ovaj korak osigurava da su sve operacije transformacije uspešno obavljene i da su podaci spremni za faze analize i modeliranja.

Prezentacija

Nakon svih faza, obrađeni podaci se prezentuju i dele unutar organizacije radi analize. Dokumentacija o koracima obrade i metapodaci se takođe dele.

Talend

Talend je objedinjena platforma za upravljanje podacima koja se fokusira na tri ključna aspekta: integraciju podataka, primenu, kao i integritet i upravljanje podacima. Obrada podataka u Talendu se vrši putem alata koji se bazira na pretraživaču, a koji omogućava grupne, serijske i aktivne pripreme podataka – profiliranje, čišćenje i dokumentovanje.

Talend data fabric upravlja svakom fazom životnog ciklusa podataka, pažljivo balansirajući dostupnost, upotrebljivost, sigurnost i integritet svih poslovnih podataka.

Da li vas brinu različiti izvori podataka? Talend nudi jedinstveni pristup koji omogućava brzu integraciju podataka iz svih vaših izvora (baze podataka, cloud skladišta i API krajnje tačke), uz transformaciju i mapiranje podataka, kao i besprekorne provere kvaliteta.

Integracija podataka u Talendu se ostvaruje putem self-service alata, kao što su konektori koji programerima omogućavaju automatizovano uvoženje podataka iz bilo kog izvora i njihovu adekvatnu kategorizaciju.

Karakteristike Talenda

Univerzalna integracija podataka

Talend omogućava kompanijama obradu bilo koje vrste podataka iz različitih izvora, bilo da su u pitanju cloud ili on-premise okruženja.

Fleksibilnost

Talend prevazilazi ograničenja dobavljača ili platformi prilikom kreiranja tokova podataka od integrisanih podataka. Jednom kada kreirate tok podataka, Talend vam omogućava da ga pokrenete bilo gde.

Kvalitet podataka

Zahvaljujući mogućnostima mašinskog učenja, kao što su deduplikacija, validacija i standardizacija, Talend automatski čisti podatke koji su u njega ubačeni.

Podrška za aplikacije i API integracije

Nakon što se analizom podataka dobije željeno značenje, podatke možete deliti preko API-ja prilagođenih korisnicima. Talend API krajnje tačke mogu izložiti vaše podatke SaaS, JSON, AVRO i B2B platformama putem alata za napredno mapiranje i transformaciju podataka.

R

R je moćan i efikasan programski jezik namenjen za istraživačku analizu podataka u naučnim i poslovnim aplikacijama.

Razvijen kao besplatan softver za statističko računanje i grafiku, R je istovremeno i jezik i okruženje za obradu, modeliranje i vizualizaciju podataka. R okruženje nudi skup softverskih paketa, dok R jezik integriše seriju statističkih, klasterizacijskih, klasifikacionih, analitičkih i grafičkih tehnika koje pomažu u manipulaciji podacima.

Karakteristike R-a

Bogat set paketa

Stručnjaci za podatke imaju na raspolaganju više od 10.000 standardizovanih paketa i ekstenzija koje mogu izabrati sa sveobuhvatne R arhivske mreže (CRAN). To pojednostavljuje obradu i analizu podataka.

Izuzetna snaga

Uz dostupne distribuirane računarske pakete, R može izvršiti složene i jednostavne matematičke i statističke manipulacije nad objektima podataka i skupovima podataka za samo nekoliko sekundi.

Podrška za više platformi

R je nezavistan od platforme i može raditi na brojnim operativnim sistemima. Takođe je kompatibilan sa drugim programskim jezicima, što olakšava manipulaciju računarski zahtevnim zadacima.

Učenje R-a je jednostavno.

Trifacta

Trifacta je interaktivno cloud okruženje za profiliranje podataka koje koristi modele mašinskog učenja i analitike. Ovaj alat za obradu podataka ima za cilj da kreira razumljive podatke, bez obzira na to koliko su skupovi podataka neuredni ili složeni. Korisnici mogu uklanjati duplikate i popunjavati prazne ćelije putem deduplikacije i linearne transformacije.

Ovaj alat za obradu podataka ima sposobnost da prepozna nepravilne i nevažeće podatke u bilo kom skupu podataka. Sa samo jednim klikom i prevlačenjem, podaci se rangiraju i inteligentno transformišu pomoću predloga koje generiše mašinsko učenje, čime se ubrzava priprema podataka.

Obrada podataka u Trifacti se odvija putem upečatljivih vizuelnih profila, što je pogodno i za tehničko i za netehničko osoblje. Kroz vizualizovane i inteligentne transformacije, Trifacta se ponosi svojim dizajnom usmerenim na korisnika.

Bez obzira da li se podaci uvoze iz baza podataka, data warehouse-a ili data lake-a, korisnici su zaštićeni od složenosti pripreme podataka.

Karakteristike Trifacte

Besprekorne Cloud integracije

Podržava pripremu podataka u bilo kom cloud ili hibridnom okruženju, omogućavajući programerima da obrađuju podatke bez obzira na to gde se nalaze.

Metode standardizacije podataka

Trifacta wrangler ima nekoliko mehanizama za identifikovanje obrazaca u podacima i standardizaciju izlaza. Inženjeri podataka mogu izabrati standardizaciju po obrascu, funkciji ili kombinovanjem.

Jednostavan radni tok

Trifacta organizuje pripremne radove u obliku tokova. Tok sadrži jedan ili više skupova podataka plus njihove povezane recepte (definisane korake koji transformišu podatke).

Tok, dakle, smanjuje vreme koje programeri provode na uvoz, obradu, profiliranje i izvoz podataka.

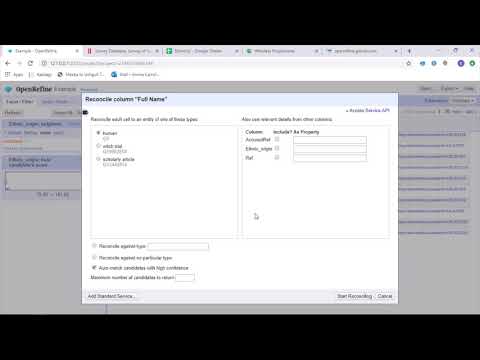

OpenRefine

OpenRefine je alat otvorenog koda namenjen za rad sa neurednim podacima. Kao alat za čišćenje podataka, OpenRefine istražuje skupove podataka za samo nekoliko sekundi, a istovremeno primenjuje složene transformacije kako bi se postigli željeni formati podataka.

OpenRefine pristupa obradi podataka kroz filtere i particije na skupovima podataka, koristeći regularne izraze. Koristeći ugrađeni General Refine Expression Language, stručnjaci mogu pregledati podatke koristeći aspekte, filtere i tehnike sortiranja, pre nego što izvrše napredne operacije ekstrakcije entiteta.

OpenRefine omogućava korisnicima da rade na podacima kao projektima, gde skupovi podataka iz više datoteka, web URL-ova i baza podataka mogu biti uvučeni u te projekte, uz mogućnost pokretanja na lokalnom računaru.

Preko izraza, programeri mogu proširiti čišćenje i transformaciju podataka na zadatke kao što su razdvajanje/spajanje ćelija sa više vrednosti, prilagođavanje aspekata i preuzimanje podataka u kolone koristeći spoljne URL adrese.

Karakteristike OpenRefine-a

Alat za više platformi

OpenRefine je napravljen za rad na Windows, Mac i Linux operativnim sistemima, putem instalacionih paketa za preuzimanje.

Bogat set API-ja

Sadrži OpenRefine API, API za proširenje podataka, API za pomirenje i druge API-je koji podržavaju interakciju korisnika sa podacima.

Datameer

Datameer je SaaS alat za transformaciju podataka, osmišljen da pojednostavi pronalaženje podataka i integraciju kroz procese softverskog inženjeringa. Datameer omogućava ekstrakciju, transformaciju i učitavanje skupova podataka u cloud skladišta kao što je Snowflake.

Ovaj alat za obradu podataka dobro funkcioniše sa standardnim formatima kao što su CSV i JSON, omogućavajući inženjerima da uvoze podatke u različitim formatima radi agregacije.

Datameer sadrži dokumentaciju podataka poput kataloga, duboko profiliranje i otkrivanje kako bi se zadovoljile sve potrebe za transformacijom podataka. Alat čuva vizuelni profil podataka koji omogućava korisnicima da prate nevažeća, nedostajuća ili neispravna polja, vrednosti i celokupan oblik podataka.

Radeći na skalabilnom skladištu podataka, Datameer transformiše podatke za smislenu analizu kroz efikasne stekove podataka i funkcije slične Excelu.

Datameer nudi hibridni, kodni i korisnički interfejs bez koda za prilagođavanje širokim timovima za analizu podataka koji mogu lako da grade složene ETL tokove.

Karakteristike Datameera

Više korisničkih okruženja

Sadrži okruženja za transformaciju podataka za različite korisnike – low-code, code i hibridno, kako bi podržao tehnološki pismene, ali i one koji to nisu.

Zajednički radni prostori

Datameer omogućava timovima da ponovo koriste i sarađuju na modelima, čime se ubrzavaju projekti.

Bogata dokumentacija podataka

Datameer podržava sistemsku i korisnički generisanu dokumentaciju podataka putem metapodataka, opisa u wiki stilu, oznaka i komentara.

Zaključak 👩🏫

Analitika podataka je složen proces koji zahteva da podaci budu adekvatno organizovani kako bi se iz njih izvukli smisleni zaključci i predviđanja. Alati za obradu podataka pomažu vam da formatirate velike količine sirovih podataka kako biste mogli da sprovedete naprednu analizu. Izaberite najbolji alat koji odgovara vašim potrebama i postanite profesionalac u analitici!

Možda će vam se svideti i:

Najbolji CSV alati za konvertovanje, formatiranje i validaciju.