Представљамо вам најраспрострањеније преваре које користе deepfake технологију.

Почнимо са једним необичним примером, где се Џо Бајден, бивши председник САД, обраћа јавности:

Овај пример наговештава како би могла изгледати гласовна превара, настала уз помоћ deepfake технологије. Заправо, коришћен је бесплатан алат за клонирање гласа уз помоћ вештачке интелигенције. За мање од пет минута, текст је написан уз помоћ ChatGTP-а и трансформисан у говор који имитира Бајденов.

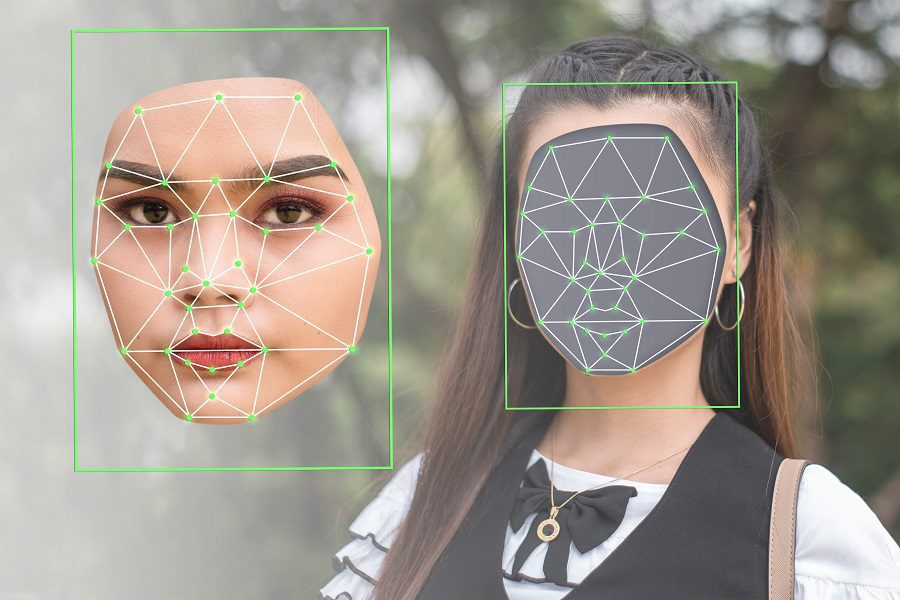

Међутим, deepfake преваре могу бити знатно софистицираније. Потребно је неколико квалитетних фотографија, видео или аудио записа особе (жртве), као и моћна графичка картица, да би се почело са креирањем.

Међутим, овде нећемо разматрати процес креирања deepfake видео снимака, нити ћемо се бавити њиховим препознавањем.

Уместо тога, овај текст представља кратак увод у deepfake технологију и наводи неколико најчешћих превара, на које треба обратити посебну пажњу.

Шта су заправо Deepfake снимци?

Термин Deepfake настао је спајањем два појма: „deep“ (што се односи на deep learning – дубоко учење, коришћено у њиховом креирању) и „fake“ (што указује на природу излазног материјала).

Укратко, алгоритми дубоког учења омогућавају стварање убедљивих слика, аудио и видео материјала, полазећи од оригиналних садржаја високе резолуције.

Ово је типичан пример deepfake технологије, који може деловати уверљиво. Међутим, овај пример је стар већ пет година, а технологија се развија веома брзо.

Ова технологија не користи се увек у забавне сврхе, нити за демонстрацију способности вештачке интелигенције. Један од озбиљнијих примера је видео у којем „господин Владимир Зеленски“ позива своје снаге на предају током рата у Украјини.

Нажалост, ово није једини такав случај. Према извештају компаније Регула Форенсицс за 2023. годину, 37% светских организација су се суочиле са гласовним deepfake преварама, 29% са синтетичким видео преварама, а 46% са покушајима крађе идентитета.

Дакле, deepfake технологија се не користи само за забаву, већ и за ширење дезинформација и у друге злонамерне сврхе, што може бити опасно и узнемирујуће за жртве.

Борба против deepfake садржаја је веома тешка. Они представљају нуспојаву напретка технологије вештачке интелигенције, као и чињенице да су ти алати постали доступни широј јавности.

Због тога је најважнија и најчешћа одбрана – свест о њиховом постојању.

Размотримо, дакле, различите типове deepfake превара.

Врсте Deepfake Превара

Deepfake преваре се могу сврстати у неколико категорија, у зависности од њиховог садржаја и циља, а то су:

- Видео лажно представљање

- Лажни интервјуи

- Лажне вести

- Гласовне преваре

- Замке за навођење

- Лажна корисничка подршка

- Лажни коментари и препоруке

У наредним одељцима ћемо детаљније размотрити наведене категорије и њихове специфичне облике.

Видео Лажно Представљање

Ово је познат облик deepfake преваре, где се креира лажни видео запис који обично имитира познате личности. Честе жртве су председници држава (као што је Обамин deepfake видео), познате холивудске звезде или директори великих компанија.

Разлог због ког су они честе мете је доступност њихових слика и говора. Алати за креирање deepfake видеа омогућавају рад са различитим уносима, приказујући широк спектар емоција, углова лица, осветљења, позадине и слично.

Намера таквих лажних представљања може бити обична забава, покушај уцене, политичка мотивација, клевета или било шта друго.

Повремено, може се десити да чланови породице траже новац или приступ вредним стварима преко лажних deepfake видео записа.

Лажни Интервјуи

Лажни интервјуи, користећи deepfake технологију, имају за циљ лажна радна места са могућношћу рада на даљину. Ове преваре покушавају да реализују deepfake видео снимке у реалном времену, користећи конференцијске програме попут Zoom-а.

Поред добијања неадекватног кандидата, циљна компанија ризикује да изложи своје ресурсе лажној особи. Зависно од делатности компаније, то може проузроковати штету не само њеним ресурсима, већ и интересима државе.

Једноставнији циљ лажних интервјуа може бити исплата у вредним валутама.

С друге стране, преваранти могу наплатити невиним кандидатима накнаду за интервју, како би их довели пред „индустријске тајкуне“ за посао из снова.

Лажне Вести

Лажне вести су најчешћи облик deepfake превара. Такве онлајн кампање дезинформисања могу представљати ризик, нарочито у незгодним ситуацијама, попут нереда и ратова.

Поред тога, може доћи до нарушавања угледа јавних личности, када њихов deepfake представник износи коментаре које никада нису изговорили у стварности.

Друштвене мреже и платформе за стриминг, као што је YouTube, доприносе ширењу таквих лажних вести. На тај начин, ствара се окружење где се обични корисници збуњују око аутентичности свега што виде.

Гласовне Преваре

Слично deepfake видео снимцима и сликама, синтетички глас представља још један трик заснован на технологији.

У једном таквом случају, Џенифер ДеСтефано, становница Аризоне, је чула своју петнаестогодишњу ћерку како плаче преко телефона, док је мушки глас тражио милион долара за њено ослобађање. Мајка је била уверена да је њено дете у опасности. Пре него што је одлучила да изврши исплату, њихов пријатељ је позвао њеног мужа и уверио га да је ћерка безбедна.

Госпођа ДеСтефано је касније описала тешку ситуацију, наводећи да је потпуно веровала гласу, не само по звуку, већ и по тону, који се поклапао са начином на који њена ћерка обично говори.

Овде је реч о клонирању гласа, које се реализује уз помоћ оригиналних аудио узорака.

Замке за Навођење

Према традиционалној дефиницији, замка за навођење је ситуација где се особа наводи на романтичну везу ради изнуђивања осетљивих информација. Ове замке обично циљају високе профиле, попут припадника војске, високих државних службеника, политичара и слично.

Са deepfake технологијом, ове замке су углавном онлајн и могу их спроводити различите особе. То значи да жртва може добијати захтеве за пријатељство од атрактивних особа путем друштвених мрежа, које брзо успостављају блиске односе са циљем финансијске или информативне изнуде.

Такве deepfake преваре су обично добро испланиране операције, које се одвијају пре постављања коначне замке.

Лажна Корисничка Подршка

Преваре техничке подршке су веома честе. Вероватно сте чули за преваре, где вас „Мајкрософт“ представник тражи да платите како бисте решили „озбиљне“ проблеме на рачунару.

Пре deepfake технологије, њихови акценти и необичан говор су указивали на злонамерне покушаје. Али сада, ти преваранти имају супермоћи које им омогућавају да лако преваре невине кориснике, стварајући утисак да разговарају са легитимним представницима компаније.

Лажни Коментари и Препоруке

Многи људи читају коментаре корисника пре куповине производа. Исто тако, провера видео коментара је још један начин куповине, који се до сада показао корисним.

Ова врста deepfake преваре представља ситуацију где ће много људи гарантовати за лош производ, утичући на одлуке о куповини и доводећи до губитка новца и времена корисника.

Има их још много!

Шта све видите на интернету осим текста?

Највише видео, слике и аудио материјале. Све се ово може манипулисати коришћењем технологије вештачке интелигенције, што ће у блиској будућности учинити интернет леглом за преваре. Поред тога, стварање deepfake садржаја постаје све лакше, што обичним корисницима отежава да остану тачно информисани.

У ситуацији где не постоји ништа што би спречило ширење злоупотребе технологије, требало би барем да покушамо да останемо у току.

П.С. Што се тиче забавних апликација, постоје deepfake апликације за креирање забавних мемова за друштвене мреже.