Algoritamska pristrasnost može imati značajan uticaj na različite aspekte naših života. Ona se može odraziti na preporuke koje dobijamo za sadržaj na internetu, na procese pronalaženja zaposlenja, pa čak i na donošenje važnih finansijskih odluka.

Ljudska priroda je takva da smo svi, na neki način, pristrasni. Različiti pojedinci se razlikuju po polu, rasi, vaspitanju, obrazovanju, kulturi, uverenjima, i životnim iskustvima.

Zbog tih razlika, njihova mišljenja, razmišljanja, preferencije i ono što im se dopada ili ne dopada se međusobno razlikuju. Ljudi mogu razviti određene predrasude, bilo pozitivne ili negativne, prema određenim kategorijama.

Slično tome, i mašine mogu drugačije percipirati ljude, objekte i događaje, zbog pristrasnosti koje su ugrađene u njihove algoritme. Usled tih pristrasnosti, sistemi veštačke inteligencije (AI) i mašinskog učenja (ML) mogu proizvesti nepravedne rezultate, nanoseći štetu ljudima na mnoge načine.

U ovom tekstu, razmotrićemo šta su algoritamske predrasude, koje vrste postoje, kako ih identifikovati i kako ih smanjiti, sa ciljem poboljšanja pravednosti rezultata.

Pa da počnemo!

Šta su algoritamske predrasude?

Algoritamska pristrasnost se odnosi na tendenciju ML i AI algoritama da reflektuju ljudske predrasude i generišu nepravedne ishode. Predrasude mogu biti zasnovane na polu, starosti, rasi, religiji, nacionalnosti, kulturi i slično.

U kontekstu veštačke inteligencije i mašinskog učenja, algoritamske predrasude su sistematske i ponavljajuće greške koje se unose u sistem, a koje dovode do nepravednih rezultata.

Predrasude u algoritmima mogu nastati iz različitih razloga, kao što su odluke o načinu prikupljanja podataka, njihovog odabira, kodiranja, ili upotrebe u treniranju algoritma, zatim iz nameravane upotrebe samog algoritma, njegovog dizajna i slično.

Na primer, možete primetiti algoritamsku pristrasnost u rezultatima pretraživača, što može dovesti do narušavanja privatnosti, stvaranja društvenih nejednakosti, i slično.

Mnogo je slučajeva algoritamskih predrasuda u različitim oblastima, kao što su izborni rezultati, širenje govora mržnje na internetu, zdravstvo, krivično pravosuđe, procesi zapošljavanja i slično. To samo pojačava postojeće predrasude u vezi sa polom, rasom, ekonomskim i društvenim statusom.

Vrste algoritamskih pristrasnosti

#1. Pristrasnost podataka

Pristrasnost podataka se javlja kada podaci koji se koriste za treniranje AI modela ne predstavljaju adekvatno stvarne scenarije ili populacije. To može rezultirati neuravnoteženim ili iskrivljenim skupovima podataka.

Izvor: TELUS International

Izvor: TELUS International

Na primer, ako je softver za prepoznavanje lica treniran uglavnom na beloj populaciji, on može imati poteškoće da prepozna ljude sa tamnijim tonovima kože, što ih stavlja u nepovoljan položaj.

#2. Pristrasnost merenja

Ova vrsta pristrasnosti može nastati usled grešaka u procesu merenja ili prikupljanja podataka.

Na primer, ako trenirate zdravstveni dijagnostički algoritam da detektuje bolest na osnovu određenih indikatora kao što su prethodne posete lekaru, to može iskriviti rasuđivanje i dovesti do pristrasnosti, tako da se stvarni simptomi mogu zanemariti.

#3. Pristrasnost modela

Pristrasnosti modela se javljaju tokom dizajniranja algoritma ili AI modela.

Na primer, ako sistem veštačke inteligencije ima algoritam koji je dizajniran da maksimizira profit bez obzira na sve, to može dovesti do toga da se finansijskim dobicima daje prednost nauštrb poslovne etike, bezbednosti, pravednosti i slično.

#4. Pristrasnost evaluacije

Pristrasnost evaluacije se može pojaviti kada su faktori ili kriterijumi za procenu performansi AI sistema pristrasni.

Izvor: Clear Review

Izvor: Clear Review

Na primer, ako sistem veštačke inteligencije za procenu učinka koristi standardizovane testove koji favorizuju određenu grupu zaposlenih u kompaniji, to može doprineti nejednakostima.

#5. Pristrasnost izveštavanja

Pristrasnost izveštavanja se može pojaviti kada skup podataka za treniranje ne odražava tačno učestalost događaja u stvarnosti.

Na primer, ako bezbednosni AI alat ne radi dobro u određenoj kategoriji, može označiti celu kategoriju kao sumnjivu.

To znači da je skup podataka na kojem je sistem treniran označio svaki istorijski incident koji se odnosi na tu kategoriju kao nesiguran, zbog veće učestalosti incidenata.

#6. Pristrasnost selekcije

Pristrasnost selekcije se javlja kada podaci za treniranje nisu odabrani na adekvatan i slučajan način, ili kada ne predstavljaju dobro celokupnu populaciju.

Na primer, ako je alatka za prepoznavanje lica trenirana na ograničenom skupu podataka, može početi da pokazuje diskriminaciju prema podacima sa kojima se ređe susreće, na primer, može lakše identifikovati muškarce i ljude svetlije puti u politici nego žene i ljude tamnije puti.

#7. Implicitna pristrasnost

Implicitna pristrasnost nastaje kada AI algoritam pravi pretpostavke zasnovane na određenim ličnim iskustvima, koja se možda ne primenjuju na šire kategorije ili ljude.

Na primer, ako naučnik za podatke koji dizajnira AI algoritam lično smatra da žene uglavnom preferiraju ružičastu boju, a ne plavu ili crnu, sistem može preporučivati proizvode u skladu s tim, što ne važi za sve žene. Mnoge preferiraju plavu ili crnu.

#8. Pristrasnost grupne atribucije

Ova pristrasnost se može pojaviti kada dizajneri algoritama primenjuju karakteristike ili osobine koje su namenjene određenim pojedincima na celu grupu, bez obzira da li su ti pojedinci zaista deo te grupe ili ne. Pristrasnost grupne atribucije je česta u alatima za zapošljavanje i prijem.

Na primer, alat za prijem može favorizovati kandidate iz određene škole, diskriminišući druge učenike koji ne pohađaju tu školu.

#9. Istorijska pristrasnost

Prikupljanje istorijskih skupova podataka je važno kada se pripremaju podaci za treniranje ML algoritma. Međutim, ako ne obratite pažnju, može doći do pristrasnosti u vašim algoritmima zbog pristrasnosti prisutnih u istorijskim podacima.

Na primer, ako trenirate AI model sa 10 godina istorijskih podataka za odabir kandidata za tehničke pozicije, to može favorizovati muške kandidate ako u podacima za treniranje ima više muškaraca nego žena.

#10. Pristrasnost etiketiranja

Tokom treniranja ML algoritama, možda ćete morati da označite velike količine podataka kako bi bili korisni. Međutim, proces označavanja podataka može varirati, stvarajući nedoslednosti i uvodeći pristrasnost u AI sistem.

Na primer, ako trenirate AI algoritam za prepoznavanje mačaka na slikama pomoću kutija, algoritam bi mogao imati problema da prepozna mačku ako joj lice nije vidljivo, dok će lako prepoznati one kojima je lice vidljivo.

To znači da je algoritam pristrasan u prepoznavanju slika mačaka koje su okrenute licem prema napred. Ne može da identifikuje mačku ako je slika snimljena iz drugog ugla, gde se vidi telo, ali ne i lice.

#11. Pristrasnost isključivanja

Izvor: ResearchGate

Izvor: ResearchGate

Pristrasnost isključivanja nastaje kada se određena osoba, grupa ljudi ili kategorija nenamerno ili namerno isključi tokom prikupljanja podataka, ako se smatra da su irelevantni. To se uglavnom dešava tokom faze pripreme podataka u ML životnom ciklusu, kada se podaci čiste i pripremaju za upotrebu.

Na primer, ako AI sistem predviđa popularnost određenog proizvoda tokom zimske sezone na osnovu njegove stope kupovine, i ako naučnik za podatke primeti neke kupovine u oktobru i ukloni te podatke misleći da su pogrešni, uzimajući standardno trajanje od novembra do januara. Međutim, postoje mesta gde zima traje i duže od tih meseci, tako da će algoritam biti pristrasan prema zemljama koje zimu imaju od novembra do januara.

Kako se predrasude uvode u algoritme?

Podaci za obuku

Glavni izvor algoritamske pristrasnosti su pristrasni podaci koji se koriste za treniranje AI i ML algoritama. Ako podaci za obuku sadrže elemente nejednakosti i predrasuda, algoritam će naučiti te elemente i zadržati predrasude.

Dizajn

Prilikom dizajniranja algoritma, programer može svesno ili nesvesno uneti lične stavove ili preferencije u AI sistem. Na taj način, AI sistem postaje pristrasan prema određenim kategorijama.

Donošenje odluka

Često, naučnici za podatke i lideri donose odluke na osnovu ličnih iskustava, okruženja, uverenja i slično. Ove odluke se takođe odražavaju u algoritmima, što doprinosi stvaranju pristrasnosti.

Nedostatak raznolikosti

Zbog nedostatka raznolikosti u razvojnom timu, članovi tima mogu stvoriti algoritme koji ne predstavljaju celokupnu populaciju. Nemaju iskustva ili izloženost drugim kulturama, sredinama, verovanjima i slično, zbog čega njihovi algoritmi mogu biti pristrasni na određeni način.

Predobrada podataka

Metode koje se koriste za čišćenje i obradu podataka mogu uvesti algoritamsku pristrasnost. Pored toga, ako se ove metode ne dizajniraju pažljivo kako bi se suprotstavile pristrasnosti, to može postati ozbiljan problem u AI modelima.

Arhitektura

Arhitektura modela i tip ML algoritma koji odaberete takođe mogu uvesti pristrasnost. Neki algoritmi su skloniji pristrasnosti od drugih, zajedno sa načinom na koji su dizajnirani.

Izbor funkcija

Karakteristike koje ste odabrali za treniranje AI algoritma mogu biti uzrok pristrasnosti. Ako ne odaberete karakteristike uzimajući u obzir njihov uticaj na pravednost rezultata, može se pojaviti pristrasnost koja će favorizovati neke kategorije.

Istorija i kultura

Ako se algoritam napaja i trenira na podacima preuzetim iz istorije ili određenih kultura, on može naslediti predrasude, verovanja, norme i slično. Ove predrasude mogu uticati na ishode veštačke inteligencije čak i ako su nepravedne i irelevantne u sadašnjosti.

Promena podataka

Podaci koje danas koristite za treniranje vaših AI algoritama mogu postati nerelevantni, beskorisni ili zastareli u budućnosti. To može biti uzrokovano promenom tehnologije ili društva. Međutim, ovi skupovi podataka i dalje mogu uneti pristrasnost i ometati performanse.

Povratne petlje

Neki sistemi veštačke inteligencije ne samo da komuniciraju sa korisnicima, već se i prilagođavaju njihovom ponašanju. Na taj način, algoritam može pojačati postojeću pristrasnost. Dakle, kada lične predrasude korisnika uđu u sistem veštačke inteligencije, on može da generiše pristrasnu povratnu petlju.

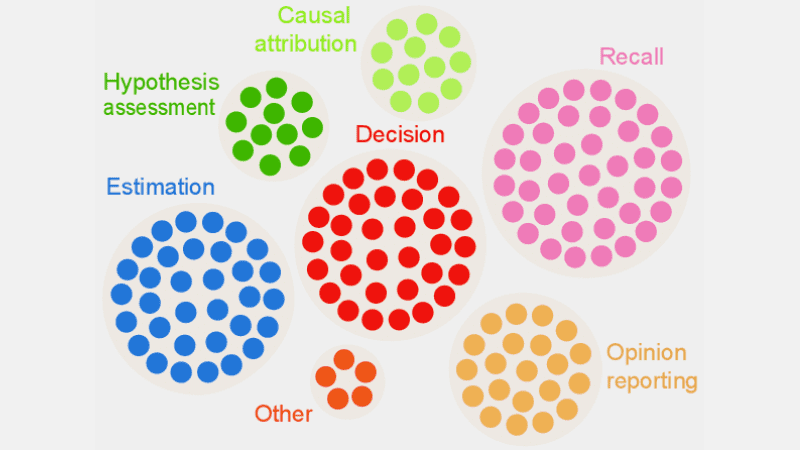

Kako otkriti algoritamsku pristrasnost?

Definišite šta je „pravedno“

Da biste otkrili nepravedne ishode ili pristrasnosti u algoritmima, morate definisati šta tačno „pravedno“ znači za AI sistem. Za to možete uzeti u obzir faktore kao što su pol, godine, rasa, seksualnost, region, kultura i slično.

Odredite metriku za izračunavanje pravednosti, kao što su jednake mogućnosti, prediktivni paritet, uticaji i slično. Kada definišete „pravednost“, postaje lakše otkriti šta nije pravedno i rešiti problem.

Analizirajte podatke za obuku

Detaljno analizirajte podatke za obuku kako biste pronašli neravnoteže i nedoslednosti u zastupljenosti različitih kategorija. Morate ispitati distribuciju karakteristika i proveriti da li odražavaju stvarnu demografiju ili ne.

Za vizualizaciju podataka, možete kreirati histograme, toplotne mape, dijagrame rasipanja i slično, kako biste istakli disparitete i obrasce koji se ne mogu otkriti samo statističkom analizom.

Osim interne analize, možete uključiti spoljne stručnjake i analitičare da procene sistemsku pristrasnost.

Izmerite performanse modela

Da biste otkrili pristrasnost, pokušajte da izmerite performanse vašeg AI modela za različite demografske kategorije i grupe. Bilo bi korisno ako podelite obuku u različite grupe na osnovu rase, pola i slično. Takođe možete koristiti svoju metriku pravednosti kako biste izračunali razlike u rezultatima.

Koristite odgovarajuće algoritme

Odaberite algoritme koji promovišu pravedne ishode i mogu se nositi sa pristrasnošću prilikom treniranja AI modela. Algoritmi koji su svesni pravednosti imaju za cilj da spreče pristrasnost, istovremeno obezbeđujući jednaka predviđanja u različitim kategorijama.

Softver za detekciju pristrasnosti

Možete koristiti specijalizovane alate i biblioteke koji su svesni pravednosti za otkrivanje pristrasnosti. Ovi alati nude metriku pravednosti, vizualizacije, statističke testove i mnogo toga drugog za otkrivanje pristrasnosti. Neki popularni su AI Fairness 360 i IBM Fairness 360.

Potražite povratne informacije od korisnika

Pitajte korisnike i klijente za povratne informacije o AI sistemu. Ohrabrite ih da daju iskrene kritike ako su osetili bilo kakvu vrstu nepravednog tretmana ili pristrasnosti u AI sistemu. Ovi podaci će vam pomoći da otkrijete probleme koji možda nisu uočeni u automatskim alatima i drugim procedurama detekcije.

Kako ublažiti pristrasnost u algoritmima

Diverzifikujte svoju kompaniju

Stvaranje raznolikosti u kompaniji i razvojnom timu omogućava brže otkrivanje i uklanjanje predrasuda. Razlog je to što korisnici koji su pogođeni predrasudama mogu ih brže primetiti.

Dakle, diverzifikujte svoju kompaniju ne samo u demografiji, već i u veštinama i stručnosti. Uključite ljude različitog pola, identiteta, rase, boje kože, ekonomskog porekla, kao i ljude sa različitim obrazovnim iskustvom i pozadinom.

Na taj način, prikupićete širok spektar perspektiva, iskustava, kulturnih vrednosti, preferencija i slično. Ovo će vam pomoći da poboljšate pravednost vaših AI algoritama, smanjujući pristrasnosti.

Promovišite transparentnost

Budite transparentni sa svojim timom u vezi sa ciljem, algoritmima, izvorima podataka i odlukama koje se tiču AI sistema. Ovo će omogućiti korisnicima da razumeju kako AI sistem funkcioniše i zašto generiše određene rezultate. Ova transparentnost će podstaći poverenje.

Algoritmi svesni pravednosti

Koristite algoritme koji su svesni pravednosti kada razvijate model, kako biste osigurali da se generišu pravedni rezultati za različite kategorije. Ovo je posebno važno ako kreirate AI sisteme za regulisane industrije, kao što su finansije, zdravstvo i slično.

Procenite performanse modela

Testirajte svoje modele da biste ispitali performanse AI u različitim grupama i podgrupama. To će vam pomoći da razumete probleme koji nisu vidljivi u sumarnim pokazateljima. Takođe možete simulirati različite scenarije da biste proverili njihov učinak u tim scenarijima, uključujući i složene.

Pratite etičke smernice

Formulišite etičke smernice za razvoj AI sistema, uz poštovanje pravednosti, privatnosti, bezbednosti i ljudskih prava. Morate primeniti te smernice u celoj organizaciji, tako da se pravednost poveća i odrazi na rezultate AI sistema.

Postavite kontrole i odgovornosti

Postavite jasne odgovornosti za sve članove tima koji rade na dizajnu, razvoju, održavanju i implementaciji AI sistema. Takođe morate postaviti odgovarajuće kontrole sa strogim protokolima i okvirima za rešavanje pristrasnosti, grešaka i drugih problema.

Osim navedenog, morate redovno sprovoditi analize kako biste smanjili pristrasnosti i težili stalnom poboljšanju. Takođe, budite u toku sa novim promenama u tehnologiji, demografiji i drugim faktorima.

Primeri algoritamskih pristrasnosti iz stvarnog sveta

#1. Amazonov algoritam

Amazon je lider u industriji e-trgovine. Međutim, njihov alat za zapošljavanje koji je koristio AI za procenu kandidata za posao prema njihovim kvalifikacijama pokazao je rodnu pristrasnost. Ovaj AI sistem je treniran pomoću biografija prethodnih kandidata za tehničke uloge.

Nažalost, podaci su imali veći broj muških aplikanata, što je AI naučio. Tako je nenamerno favorizovao muške kandidate u tehničkim ulogama u odnosu na žene, koje su bile nedovoljno zastupljene. Amazon je morao da ukine ovaj alat 2017. godine, uprkos naporima da smanji pristrasnost.

#2. Rasistički algoritmi zdravstvene zaštite u SAD

Algoritam koji su bolnice u SAD koristile za predviđanje pacijenata kojima je potrebna dodatna nega bio je veoma pristrasan prema belim pacijentima. Sistem je procenjivao medicinske potrebe pacijenata na osnovu istorije njihovih troškova zdravstvene zaštite, povezujući troškove sa medicinskim potrebama.

Algoritam sistema nije uzimao u obzir način na koji su beli i crni pacijenti plaćali svoje zdravstvene usluge. Crni pacijenti su uglavnom plaćali samo hitne slučajeve, bez obzira na ozbiljnost bolesti. Zbog toga su kategorisani kao zdraviji pacijenti i nisu se kvalifikovali za dodatnu negu u poređenju sa belim pacijentima.

#3. Google-ov diskriminišući algoritam

Otkriveno je da Google-ov sistem za online oglašavanje diskriminiše. Pokazao je da se oglasi za dobro plaćene pozicije, kao što su generalni direktori, mnogo češće prikazuju muškarcima nego ženama. Iako su 27% američkih izvršnih direktora žene, njihova zastupljenost je mnogo manja u oglasima na Google-u, oko 11%.

Algoritam je mogao doći do ovog rezultata učenjem ponašanja korisnika, na primer, ako muškarci češće gledaju i klikću na oglase za dobro plaćene uloge, AI algoritam će te oglase prikazivati muškarcima češće nego ženama.

Zaključak

Algoritamska pristrasnost u ML i AI sistemima može dovesti do nepravednih rezultata. Ovi rezultati mogu uticati na pojedince u različitim oblastima, od zdravstva, sajber bezbednosti i e-trgovine do izbora, zapošljavanja i slično. To može dovesti do diskriminacije na osnovu pola, rase, demografije, seksualne orijentacije i drugih aspekata.

Stoga je važno smanjiti predrasude u AI i ML algoritmima kako bi se promovisala pravednost rezultata. Gore navedene informacije će vam pomoći da otkrijete predrasude i smanjite ih, kako biste mogli da kreirate pravedne AI sisteme za korisnike.

Takođe možete čitati o upravljanju veštačkom inteligencijom.