Колико често се уздате у чет ботове или системе засноване на вештачкој интелигенцији (AI) како бисте обавили посао или дошли до одговора на ваша питања?

Ако је ваш одговор „често!“ или „стално!“, онда имате разлога за опрез 😟.

Било да сте студент који темељно користи AI ботове за претраживање материјала за писање, или програмер који покушава да генерише код искључиво помоћу AI, вероватноћа нетачности у резултатима које AI генерише је прилично велика – нарочито због недоследности или нетачних информација у AI базама података за тренирање.

Иако модели вештачке интелигенције и машинског учења (ML) мењају свет – преузимајући рутинске задатке и решавајући разне проблеме помоћу аутоматизације, још увек постоји простор за побољшање када је у питању генерисање прецизних излазних података на основу задатих упита.

Ако проведете значајно време користећи генераторе садржаја и четботове, ускоро ћете схватити да добијате нетачне, нерелевантне или једноставно измишљене одговоре. Ове појаве називају се халуцинације или конфабулације AI и представљају озбиљан проблем за организације и појединце који се ослањају на генеративне AI ботове.

Без обзира да ли сте искусили AI халуцинације или не, и желите да сазнате више, овај чланак детаљно истражује ову тему. Размотрићемо шта AI халуцинација подразумева, зашто се дешава, примери и да ли је могуће поправити је.

Крећемо!

Шта је заправо AI халуцинација?

AI халуцинација је ситуација када AI модел или модел великог језика (LLM) ствара лажне, непрецизне или нелогичне информације. AI модел генерише самоуверен одговор који заправо није у складу са његовим тренираним подацима, представљајући те информације као чињеницу, иако нема логичног смисла или оправдања!

И кажу да је грешити људски!😅

AI алати и модели, попут ChatGPT, су обично тренирани да предвиде речи које најбоље одговарају постављеном упиту. Иако ботови често дају тачне и чињеничне одговоре, понекад овај алгоритам не успева у разумевању – због чега четботови избацују чињеничне неконзистентности и погрешне изјаве.

Другим речима, AI модели понекад „халуцинирају“ одговор у покушају да вам (кориснику) угоде – настојећи да буду убедљивији, пристраснији, специјализованији или кориснији.

AI халуцинације могу да варирају од малих недоследности до потпуно нетачних или измишљених одговора. Ево типова AI халуцинација које можете искусити:

#1. Контрадикција у реченици: Ово се дешава када LLM модел генерише реченицу која је у потпуној супротности са претходном.

#2. Чињенична контрадикција: Овај тип халуцинације се јавља када AI модел представља лажне или измишљене информације као чињеницу.

#3. Контрадикција упита: Ова врста халуцинације се јавља када је излаз у супротности са упитом за који се генерише. На пример, ако је упит „Напишите позивницу пријатељима за рођенданску забаву“, модел може генерисати излаз попут „Срећна годишњица, мама и тата“.

#4. Насумичне или нерелевантне халуцинације: Ова халуцинација се дешава када модел генерише потпуно нерелевантан излаз на дати упит. На пример, ако је упит „Шта је посебно у Њујорку?“, можда ћете добити одговор: „Њујорк је један од најнасељенијих градова у Америци. Пси су најверније животиње и најбољи човеков пријатељ.“

Прочитајте и: Како генеративна AI претрага мења претраживаче

Примери AI халуцинација

AI халуцинације имају неке значајне примере и инциденте које не смете пропустити. Ево неких злогласних примера AI халуцинација:

- Google-ов четбот, Bard, лажно је тврдио да је свемирски телескоп Џејмс Веб направио прве слике планете егзопланете која не припада нашем соларном систему.

- Meta-ин Galactica LLM демо из 2022, намењен студентима и истраживачима науке, дао је својим корисницима нетачне информације и лажни папир када је упитан за нацрт рада о креирању аватара.

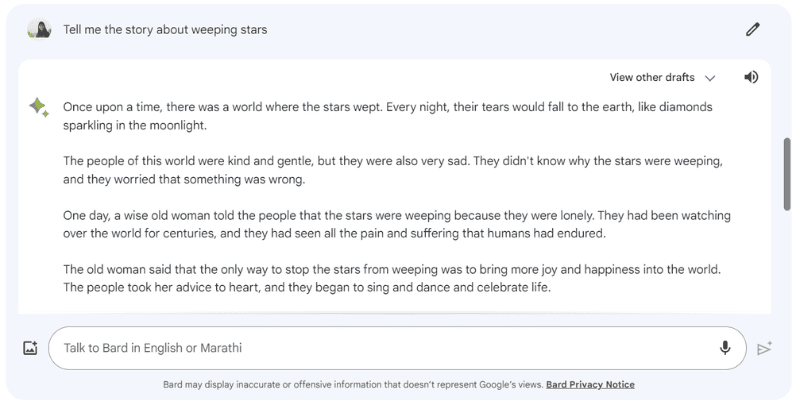

Ево примера Google Bard-а који је халуцинирао одговор када сам га питао: „Испричај ми причу о звездама које плачу“, што заправо не постоји.

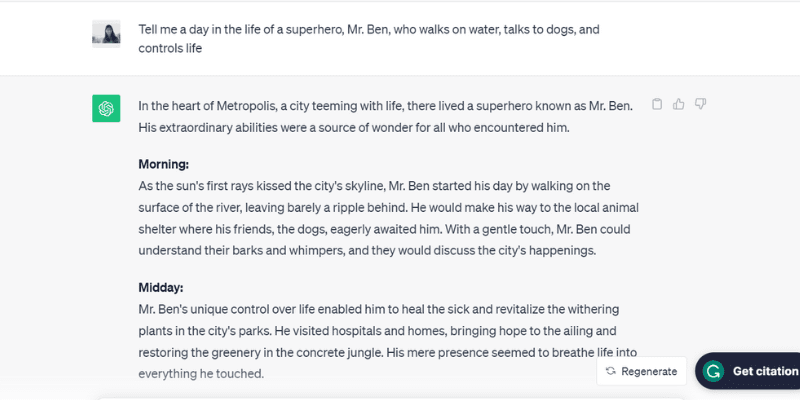

Ево још једног тестираног примера ChatGPT-а (GPT-3.5) који халуцинира причајући о измишљеној особи, господину Бену, када сам га питао: „Испричајте ми дан у животу суперхероја, господина Бена, који хода по води, разговара са псима и контролише живот.“

ChatGPT је буквално измислио цео дан, од јутра до вечери, рутину господина Бена, који заправо не постоји – али се играо са упитом који му је дат, што је један од разлога за AI халуцинације.

Прича о превеликој жељи да се угоди!

Дакле, који су разлози? Хајде да видимо још неке од узрока AI халуцинација.

Зашто долази до AI халуцинација?

Постоји неколико техничких разлога и узрока AI халуцинација. Ево неких од могућих разлога:

- Лош квалитет, недовољни или застарели подаци: LLM и AI модели се у великој мери ослањају на податке за тренирање. Дакле, њихова ефикасност је ограничена квалитетом података на којима су обучени. Ако AI алатка има грешке, недоследности, пристрасности или неефикасности у подацима за тренирање, или ако једноставно не разуме тражени упит – створиће AI халуцинације јер алат генерише резултат из ограниченог скупа података.

- Преоптерећење: Пошто су тренирани на ограниченом скупу података, AI модели могу покушати да запамте упите и одговарајуће излазе – чинећи их неспособним за ефикасно генерисање или генерализовање нових података, што доводи до AI халуцинација.

- Контекст уноса: AI халуцинације се такође могу јавити због нејасних, нетачних, недоследних или контрадикторних упутстава. Иако корисници немају приступ скупу података за тренирање AI модела, унос који уносе као упит јесте у њиховим рукама. Стога је од кључне важности дати јасне упите како би се избегле AI халуцинације.

- Употреба идиома или сленг израза: Ако упит садржи идиоме или сленг, велике су шансе за AI халуцинације, посебно ако модел није трениран на таквим речима или сленг изразима.

- Напади противника: Нападачи понекад намерно уносе упите дизајниране да збуне AI моделе, оштете њихове податке за тренирање и резултирају AI халуцинацијама.

Негативне последице AI халуцинација

AI халуцинације су главна етичка брига са значајним последицама за појединце и организације. Ево различитих разлога због којих су AI халуцинације велики проблем:

- Ширење дезинформација: AI халуцинације, због нетачних упутстава или недоследности у подацима за тренирање, могу довести до масовног ширења дезинформација, утичући на широк спектар појединаца, организација и владиних агенција.

- Неповерење међу корисницима: Када се дезинформације које AI халуцинира шире интернетом као пожар, чинећи да изгледају ауторитетно и као да су писане од стране људи, то нарушава поверење корисника – отежавајући поверење у информације на интернету.

- Штета корисницима: Поред етичких питања и обмањивања појединаца, AI халуцинације такође могу потенцијално да нашкоде људима ширењем дезинформација о неким озбиљним проблемима и темама, као што су болести, њихови лекови или једноставни савети за разликовање отровних и јестивих печурака. Чак и мала дезинформација или непрецизност могу угрозити људске животе.

Најбоље праксе за уочавање и спречавање AI халуцинација

С обзиром на горе наведене негативне импликације AI халуцинација, њихово спречавање је кључно по сваку цену. Док компаније које поседују ове AI моделе марљиво раде на елиминисању или смањењу AI халуцинација, предузимање мера предострожности са наше стране, као корисника, је веома важно.

На основу малог истраживања, мог искуства и покушаја и грешака, саставио сам неколико стратегија за уочавање и спречавање AI халуцинација следећи пут када будете користили четбота или комуницирали са моделом великог језика (LLM).

#1. Користите репрезентативне и разноврсне податке за обуку

Као корисник, од кључне је важности да користите LLM са разноврсним скупом података за обуку који представља стварни свет, смањујући вероватноћу да ће резултат бити пристрасан, непрецизан или измишљен.

У исто време, власници компанија морају да обезбеде да редовно ажурирају и проширују скупове података за обуку AI модела како би узели у обзир и били у току са културним, политичким и другим догађајима који се развијају.

#2. Ограничите излазе или одговоре

Као корисник, можете ограничити број потенцијалних одговора које AI алат може да генерише тако што ћете му дати конкретан упит о врсти одговора коју желите.

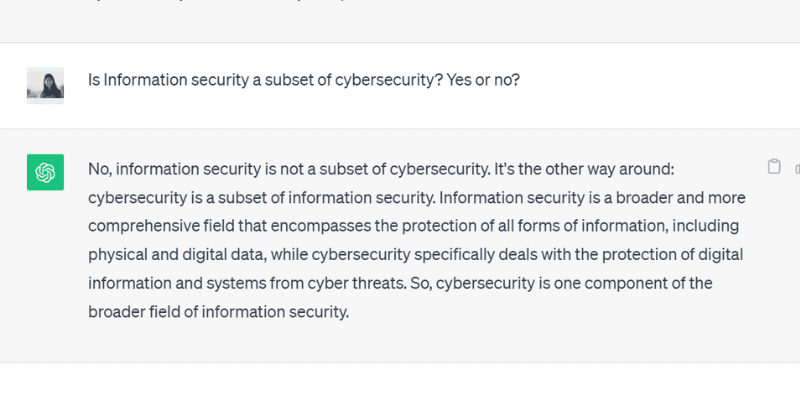

На пример, можете експлицитно да захтевате упит и наложите моделу да одговори само са „да“ или „не“. Или, такође можете дати више избора у оквиру упита за алат за избор, ограничавајући његову могућност да одступи од стварног одговора и халуцинира.

Када сам поставио питање ChatGPT GPT 3.5 са одговором „да“ или „не“, он је тачно генерисао овај излаз:

#3. Спакујте и утемељите модел релевантним подацима

Не можете очекивати да човек пружи решење за било које конкретно питање без претходног знања или давања специфичног контекста. Слично томе, AI модел је добар онолико колико је добар скуп података за тренирање који сте му дали.

Утемељење или паковање података за тренирање AI модела релевантним подацима и информацијама специфичним за индустрију даје моделу додатни контекст и тачке података. Овај додатни контекст помаже AI моделу да побољша своје разумевање – омогућавајући му да генерише тачне, разумне и контекстуалне одговоре уместо халуцинираних одговора.

#4. Направите шаблоне података које ће AI модел пратити

Обезбеђивање шаблона података или примера специфичне формуле или прорачуна у унапред дефинисаном формату може значајно помоћи AI моделу да генерише тачне одговоре, у складу са прописаним смерницама.

Ослањање на смернице и шаблоне података смањује вероватноћу халуцинација AI модела и обезбеђује доследност и тачност у генерисаним одговорима. Дакле, давање референтног модела у формату табеле или примера може заправо водити AI модел у прорачуну – елиминишући случајеве халуцинације.

#5. Будите веома конкретни са упитом, додељивањем одређене улоге моделу

Додељивање специфичних улога AI моделу је један од најефикаснијих начина за спречавање халуцинација. На пример, можете дати упите попут: „Ви сте искусан и вешт гитариста“ или „Ви сте бриљантан математичар“, а затим поставити конкретно питање.

Додељивање улога води модел да пружи одговор који желите, уместо измишљених, халуцинираних одговора.

И не брини. Још увек можете да се забавите са вештачком интелигенцијом (без обзира на халуцинације). Погледајте како сами да креирате виралну спиралну AI уметност!

#6. Тестирајте га температуром

Температура игра кључну улогу у одређивању степена халуцинација или креативних одговора које AI модел може да генерише.

Док нижа температура обично означава детерминистичке или предвидљиве резултате, виша температура значи да је већа вероватноћа да ће AI модел генерисати насумичне одговоре и халуцинирати.

Неколико компанија са вештачком интелигенцијом обезбеђује траку или клизач „Температура“ са својим алатима како би корисници могли да подесе температуру према својим жељама.

У исто време, компаније такође могу да поставе подразумевану температуру, омогућавајући алату да генерише разумне одговоре и успостави праву равнотежу између тачности и креативности.

#7. Увек проверите

На крају, ослањање на 100% излаз генерисан AI без провере или провере чињеница није паметан потез.

Док компаније и AI истраживачи решавају проблем халуцинација и развијају моделе који спречавају овај проблем, као корисник, кључно је да проверите одговоре које AI модел генерише пре него што га употребите или у потпуности поверујете у њега.

Дакле, поред коришћења горе наведених најбољих пракси, од израде нацрта упита са спецификацијама до додавања примера у упит за вођење AI, увек морате да верификујете и проверите излаз који AI модел генерише.

Да ли је могуће у потпуности поправити или елиминисати AI халуцинације? Мишљење стручњака

Иако контрола AI халуцинација зависи од одзива који му дајемо, понекад модел генерише излаз са таквим самопоуздањем да је тешко разликовати шта је лажно, а шта истина.

Дакле, на крају, да ли је могуће у потпуности поправити или спречити AI халуцинације?

Када је постављено ово питање, Суреш Венкатасубраманиан, професор Универзитета Браун, одговорио је да је питање да ли се AI халуцинације могу спречити или не „тачка активног истраживања“.

Разлог за ово, како је даље објаснио, је природа ових AI модела – колико су ти AI модели сложени, замршени и осетљиви. Чак и мала промена у брзом уносу може значајно променити излаз.

Док Венкатасубраманиан сматра решавање проблема са AI халуцинацијама тачком истраживања, Џевин Вест, професор Универзитета у Вашингтону и суоснивач Центра за информисану јавност, верује да AI халуцинације никада неће нестати.

Вест сматра да је немогуће обрнути инжењеринг халуцинација које се јављају код AI ботова или четботова. И стога, AI халуцинације могу увек бити присутне као суштинска карактеристика AI.

Штавише, Сундар Пичаи, извршни директор компаније Google, рекао је у интервјуу за CBS да се сви који користе AI сусрећу са халуцинацијама, али да нико у индустрији још увек није решио проблем халуцинација. Скоро сви AI модели се суочавају са овим проблемом. Он је такође тврдио и уверио да ће поље AI ускоро напредовати када је у питању превазилажење AI халуцинација.

У исто време, Сем Алтман, извршни директор компаније ChatGPT-макер OpenAI, посетио је Индијски институт за информационе технологије Индрапрастха, Делхи, у јуну 2023, где је приметио да ће проблем AI халуцинација бити у много бољем стању за годину или две.

Он је даље додао да би модел морао да научи разлику између тачности и креативности и када треба користити једно или друго.

Завршна реч

AI халуцинације су привукле велику пажњу последњих година и у фокусу су компанија и истраживача који покушавају да их реше и превазиђу што је пре могуће.

Иако је AI постигао изванредан напредак, није имун на грешке, а проблем AI халуцинација представља значајне изазове за неколико појединаца и индустрија, укључујући здравство, генерисање садржаја и аутомобилску индустрију.

Док истраживачи раде свој део посла, наша је одговорност као корисника да пружимо конкретне и тачне упите, додамо примере и обезбедимо шаблоне података како бисмо искористили валидне и разумне одговоре, избегли петљање са подацима за тренирање AI модела и спречили халуцинације.

Чак и ако се AI халуцинације могу у потпуности излечити или поправити, и даље остаје отворено питање; лично верујем да има наде и да можемо да наставимо да користимо AI системе за добробит света одговорно и безбедно.

Следећи примери AI (вештачке интелигенције) у нашем свакодневном животу.