Алгоритамска пристрасност може утицати на различите аспекте наших живота, од добијања препорука за онлајн садржај до проналажења послова и доношења финансијских одлука.

Пристрасност је у људској природи. Различити људи имају различит пол, расе, васпитање, образовно позадину, културу, веровања, искуства итд.

Дакле, њихова мишљења, мисли, свиђања и несвиђања и преференције се разликују једни од других. Они могу развити одређене предрасуде према или против одређених категорија.

Машине се не разликују. Они такође могу другачије да виде људе, ствари и догађаје због пристрасности уведених у њихове алгоритме. Због ових пристрасности, АИ и МЛ системи могу произвести неправедне резултате, ометајући људе на много начина.

У овом чланку ћу разговарати о томе шта су алгоритамске предрасуде, њихове врсте и како их открити и смањити како би се побољшала праведност резултата.

Почнимо!

Преглед садржаја

Шта су алгоритамске предрасуде?

Алгоритамска пристрасност је тенденција МЛ и АИ алгоритама да одражавају људске пристрасности и генеришу неправедне резултате. Предрасуде могу бити засноване на полу, старости, раси, вери, етничкој припадности, култури итд.

У контексту вештачке интелигенције и машинског учења, алгоритамске предрасуде су систематске, поновљиве грешке унете у систем које производе неправедне резултате.

Предрасуде у алгоритмима могу настати из много разлога, као што су одлуке везане за то како се подаци прикупљају, бирају, кодирају или користе у обуци алгоритма, намеравана употреба, дизајн алгоритма итд.

Пример: Можете да приметите алгоритамску пристрасност у резултатима претраживача, што доводи до кршења приватности, друштвених пристрасности итд.

Постоји много случајева алгоритамских пристрасности у областима као што су изборни исходи, ширење говора мржње на мрежи, здравство, кривично правосуђе, регрутовање, итд. Ово отежава постојеће предрасуде у погледу пола, расе, економије и друштва.

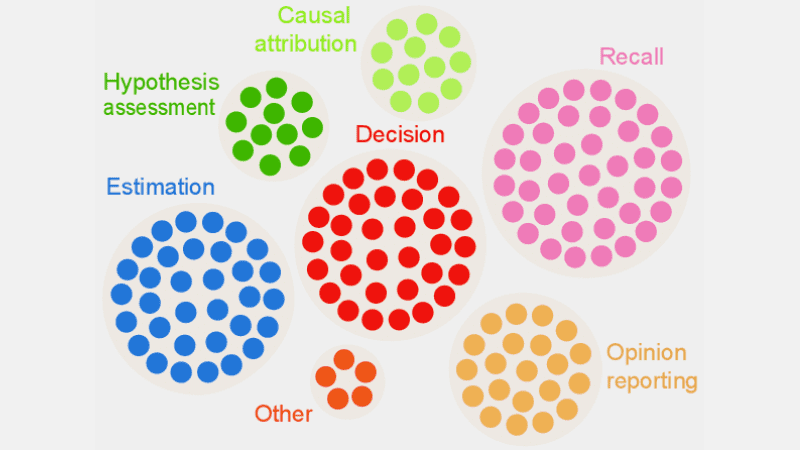

Врсте алгоритамских пристрасности

#1. Дата Биас

Пристрасност података се дешава када подаци потребни за обуку АИ модела не представљају правилно сценарије или популације из стварног света. Ово може довести до неуравнотежених или искривљених скупова података.

Извор: ТЕЛУС Интернатионал

Извор: ТЕЛУС Интернатионал

Пример: Претпоставимо да је софтверско решење за препознавање лица обучено првенствено за белу популацију. Дакле, може лоше да ради када има задатак да препозна људе са тамнијим тоновима коже, што утиче на њих.

#2. Меасуремент Биас

Ова пристрасност може настати због грешке у процесу мерења или прикупљања података.

Пример: Ако обучите здравствени дијагностички алгоритам да открије болест на основу неких показатеља као што су претходне посете лекару, то може да замагли расуђивање и изазове пристрасност док се превиде стварни симптоми.

#3. Модел Биас

Пристрасности модела настају током дизајнирања алгоритма или АИ модела.

Пример: Претпоставимо да систем вештачке интелигенције има алгоритам који је дизајниран да максимизира профит без обзира на то како; могло би се завршити давањем приоритета финансијским добитима по цену пословне етике, сигурности, правичности итд.

#4. Евалуатион Биас

Пристрасност евалуације може настати када су фактори или критеријуми за процену перформанси АИ система пристрасни.

Извор: Цлеар Ревиев

Извор: Цлеар Ревиев

Пример: Ако систем вештачке интелигенције за процену учинка користи стандардне тестове који фаворизују одређену категорију запослених у компанији, то може да промовише неједнакости.

#5. Репортинг Биас

Пристрасност извештавања може да се јави када скуп података за обуку нема тачан одраз стварности у учесталости догађаја.

Пример: Ако безбедносни алат АИ не ради добро у одређеној категорији, може означити целу категорију као сумњиву.

То значи да је скуп података за који је систем обучен означио сваки историјски инцидент који се односи на ту категорију као несигуран због веће учесталости инцидената.

#6. Пристрасност избора

Пристрасност селекције настаје када су подаци о обуци одабрани без одговарајуће рандомизације или не представљају добро укупну популацију.

Пример: Ако је алатка за препознавање лица обучена на ограниченим подацима, може почети да показује неку дискриминацију према подацима са којима се мање сусреће, као што је идентификација обојених жена у политици него код мушкараца и особа светлије пути у политици.

#7. Имплицитна пристрасност

Имплицитна пристрасност настаје када алгоритам АИ прави претпоставке засноване на одређеним личним искуствима, што се можда не односи на шире категорије или људе експлицитно.

Пример: Ако научник података који дизајнира АИ алгоритам лично верује да жене првенствено воле ружичасту, а не плаву или црну, систем може да препоручи производе у складу са тим, што се не односи на сваку жену. Многи воле плаву или црну.

#8. Пристрасност групне атрибуције

Ова пристрасност се може десити када дизајнери алгоритама примењују ствари које су намењене одређеним појединцима на комплетну групу, без обзира да ли су ти појединци део групе или не. Пристрасност групне атрибуције је уобичајена у алатима за запошљавање и пријем.

Пример: Инструмент за упис може фаворизовати кандидате из одређене школе, дискриминишући друге ученике који не припадају тој школи.

#9. Хисторицал Биас

Прикупљање историјских скупова података је важно када се прикупљају скупови података за обуку МЛ алгоритма. Али ако не обратите пажњу, може доћи до пристрасности у вашим алгоритмима због пристрасности присутних у вашим историјским подацима.

Пример: Ако обучите модел вештачке интелигенције са 10 година историјских података да бисте ушли у ужи избор кандидата за техничке позиције, то би могло дати предност мушким кандидатима ако подаци о обуци имају више мушкараца него жена.

#10. Лабел Биас

Док обучавате МЛ алгоритме, можда ћете морати да означите много података како би били корисни. Међутим, процес означавања података може много да варира, стварајући недоследности и уводећи пристрасност у систем вештачке интелигенције.

Пример: Претпоставимо да тренирате АИ алгоритам означавањем мачака на сликама помоћу кутија. Ако не обратите пажњу, алгоритам би могао да не успе да идентификује мачку на слици ако њено лице није видљиво, али може да идентификује оне са мачјим лицима на њима.

То значи да је алгоритам пристрасан у идентификацији слика са мачкама окренутим напред. Не може да идентификује мачку ако је слика снимљена из другог угла када се види тело, али не и лице.

#11. Пристрасност искључења

Извор: РесеарцхГате

Извор: РесеарцхГате

Пристрасност искључивања настаје када се одређена особа, група људи или категорија ненамерно или намерно искључи током прикупљања података ако се сматра да су ирелевантни. То се углавном дешава током фазе припреме података животног циклуса МЛ-а у време чишћења података и њихове припреме за употребу.

Пример: Претпоставимо да систем предвиђања заснован на вештачкој интелигенцији мора да одреди популарност одређеног производа током зимске сезоне на основу његове стопе куповине. Дакле, ако научник података примети неке куповине у октобру и уклони те записе, мислећи да су погрешни и узимајући стандардно трајање од новембра до јануара. Али има места када зима превазилази те месеце. Дакле, алгоритам ће бити пристрасан према земљама које примају зиму од новембра до јануара.

Како се предрасуде уводе у алгоритме?

Подаци о обуци

Главни извор алгоритамске пристрасности су пристрасни подаци који се користе за обуку АИ и МЛ алгоритама. Ако сами подаци о обуци садрже елементе неједнакости и предрасуда, алгоритам ће научити те елементе и одржавати предрасуде.

Дизајн

Када дизајнира алгоритам, програмер може свесно или несвесно да уведе рефлексије личних мисли или преференција у АИ систем. Дакле, АИ систем ће бити пристрасан према одређеним категоријама.

Одлучивати

Много пута, научници података и лидери доносе одлуке на основу својих личних искустава, окружења, уверења итд. Ове одлуке се такође одражавају у алгоритмима, што узрокује пристрасности.

Недостатак разноликости

Због недостатка разноликости у развојном тиму, чланови тима на крају стварају алгоритме који не представљају целу популацију. Они немају искуства или изложеност другим културама, позадинама, веровањима, начинима итд., због чега њихови алгоритми могу бити пристрасни на одређени начин.

Предобрада података

Метода која се користи за чишћење и обраду података може увести алгоритамску пристрасност. Поред тога, ако пажљиво не дизајнирате ове методе како бисте се супротставили пристрасности, то би могло постати озбиљно у АИ моделу.

Архитектура

Архитектура модела и тип МЛ алгоритма који одаберете такође могу да уведу пристрасност. Неки алгоритми привлаче пристрасност више од других, заједно са начином на који су дизајнирани.

Избор функција

Карактеристике које сте изабрали да тренирате АИ алгоритам су један од узрока пристрасности. Ако не одаберете карактеристике узимајући у обзир њихов утицај на праведност резултата, може се појавити одређена пристрасност, фаворизујући неке категорије.

Историја и култура

Ако се алгоритам храни и обучава на подацима преузетим из историје или одређених култура, он може наследити предрасуде, веровања, норме, итд. Ове предрасуде могу утицати на исходе вештачке интелигенције чак и ако су неправедне и ирелевантне у садашњости.

Дата Дрифт

Подаци које данас користите за обуку својих алгоритама вештачке интелигенције могу постати небитни, бескорисни или застарели у будућности. Ово може бити због промене технологије или друштва. Међутим, ови скупови података и даље могу да унесу пристрасност и ометају перформансе.

Повратне спреге

Неки системи вештачке интелигенције не само да могу да комуницирају са корисницима већ се и прилагођавају њиховом понашању. На овај начин, алгоритам може повећати постојећу пристрасност. Дакле, када личне предрасуде корисника уђу у систем вештачке интелигенције, он може да генерише пристрасну повратну петљу.

Како открити алгоритамску пристрасност?

Дефинишите шта је „поштено“

Да бисте открили неправедне исходе или пристрасности у алгоритмима, морате да дефинишете шта тачно „фер“ подразумева за систем вештачке интелигенције. За ово можете узети у обзир факторе као што су пол, године, раса, сексуалност, регион, култура итд.

Одредите метрику за израчунавање правичности, као што су једнаке могућности, предиктивни паритет, утицаји, итд. Једном када дефинишете „правичност“, постаје вам лакше да откријете шта није фер и решите ситуацију.

Подаци о обуци ревизије

Детаљно анализирајте своје податке о обуци да бисте пронашли неравнотеже и недоследности у представљању различитих категорија. Морате испитати дистрибуцију карактеристика и проверити да ли представља стварну демографију или не.

За визуелизацију података, можете креирати хистограме, топлотне мапе, дијаграме расејања итд. да бисте истакли диспаритете и обрасце који се не могу открити уз помоћ само статистичке анализе.

Осим интерних ревизија, можете укључити спољне стручњаке и ревизоре да процене системску пристрасност.

Измерите перформансе модела

Да бисте открили пристрасности, покушајте да измерите перформансе вашег АИ модела за различите демографске категорије и категорије. Помогло би ако обуку поделите у различите групе на основу расе, пола итд. Такође можете да користите своју метрику праведности да бисте израчунали разлике у резултатима.

Користите одговарајуће алгоритме

Изаберите алгоритме који промовишу поштене резултате и могу да се позабаве пристрасношћу у обучавању АИ модела. Алгоритми који су свесни правичности имају за циљ да спрече пристрасност, истовремено обезбеђујући једнака предвиђања у различитим категоријама.

Софтвер за откривање пристрасности

Можете користити специјализоване алате и библиотеке које су свесне правичности да бисте открили пристрасности. Ови алати нуде метрику праведности, визуализације, статистичке тестове и још много тога за откривање пристрасности. Неки популарни су АИ Фаирнесс 360 и ИБМ Фаирнесс 360.

Потражите повратне информације корисника

Питајте кориснике и купце за повратне информације о АИ систему. Охрабрите их да дају своје искрене критике ако су осетили било какву врсту неправедног третмана или пристрасности у систему вештачке интелигенције. Ови подаци ће вам помоћи да откријете проблеме који можда нису означени у аутоматизованим алатима и другим процедурама за откривање.

Како ублажити пристрасност у алгоритмима

Диверзификујте своју компанију

Стварање разноликости у вашој компанији и развојном тиму омогућава брже откривање и уклањање предрасуда. Разлог је то што корисници који су погођени њима могу брзо приметити пристрасности.

Дакле, диверзификујте своју компанију не само у демографији, већ иу вештинама и стручности. Укључите људе различитог пола, идентитета, раса, боја коже, економског порекла итд., као и људе са различитим образовним искуством и позадином.

На овај начин ћете прикупити широк спектар перспектива, искустава, културних вредности, допадања и несвиђања, итд. Ово ће вам помоћи да побољшате праведност ваших алгоритама вештачке интелигенције, смањујући пристрасности.

Промовишите транспарентност

Будите транспарентни са својим тимом у вези са циљем, алгоритмима, изворима података и одлукама у вези са системом вештачке интелигенције. Ово ће омогућити корисницима да разумеју како АИ систем функционише и зашто генерише одређене резултате. Ова транспарентност ће подстаћи поверење.

Алгоритми свесни праведности

Користите алгоритме који су свесни правичности када развијате модел како бисте осигурали да се правични резултати генеришу за различите категорије. Ово постаје очигледно ако креирате АИ системе за високо регулисане индустрије као што су финансије, здравство итд.

Процените перформансе модела

Тестирајте своје моделе да бисте испитали перформансе АИ у различитим групама и подгрупама. То ће вам помоћи да разумете проблеме који нису видљиви у збирним показатељима. Такође можете симулирати различите сценарије да бисте проверили њихов учинак у тим сценаријима, укључујући сложене.

Пратите етичке смернице

Формулишите неке етичке смернице за развој АИ система, поштујући правичност, приватност, безбедност и људска права. Морате да примените те смернице у целој организацији тако да се правичност повећа у целој организацији и да се одрази на резултате АИ система.

Поставите контроле и одговорности

Поставите јасне одговорности за све у тиму који раде на дизајну, развоју, одржавању и примени АИ система. Такође морате поставити одговарајуће контроле са стриктним протоколима и оквирима за решавање пристрасности, грешака и других проблема.

Осим горе наведеног, морате да спроводите редовне ревизије како бисте смањили пристрасности и тежили сталним побољшањима. Такође, будите у току са недавним променама у технологији, демографији и другим факторима.

Примери алгоритамских пристрасности из стварног света

#1. Амазонов алгоритам

Амазон је лидер у индустрији е-трговине. Међутим, његова алат за запошљавање који је користио АИ за процену кандидата за посао према њиховим квалификацијама показао је родну пристрасност. Овај систем вештачке интелигенције је обучен коришћењем животописа претходних кандидата у техничким улогама.

Нажалост, подаци су имали већи број мушких апликаната, што је АИ сазнао. Дакле, ненамерно је фаворизовао мушке кандидате у техничким улогама у односу на жене које су биле недовољно заступљене. Амазон је морао да прекине ову алатку 2017. године упркос напорима да смањи пристрасност.

#2. Расистички алгоритми здравствене заштите у САД

Алгоритам који су болнице са седиштем у САД користиле за предвиђање пацијената којима је потребна додатна нега био је веома тежак пристрасан према белим пацијентима. Систем је проценио медицинске потребе пацијената на основу историје њихових трошкова здравствене заштите, повезујући трошкове са медицинским потребама.

Алгоритам система није узео у обзир како су бели и црни пацијенти плаћали своје здравствене потребе. Упркос неконтролисаној болести, црни пацијенти плаћали су углавном хитне случајеве. Дакле, они су категорисани као здравији пацијенти и нису се квалификовали за додатну негу у односу на беле пацијенте.

#3. Гоогле-ов дискриминирајући алгоритам

Пронађен је Гоогле-ов систем за оглашавање на мрежи дискриминишући. Показао је да су високо плаћене позиције попут генералних директора мушкарцима знатно веће од жена. Чак и ако су 27% америчких извршних директора жене, њихова заступљеност је много мања у Гуглу, око 11%.

Алгоритам је могао да покаже резултат учењем понашања корисника, као што су људи који гледају и кликну на огласе за високо плаћене улоге мушкарци; АИ алгоритам ће те огласе приказивати мушкарцима више него женама.

Закључак

Алгоритамска пристрасност у МЛ и АИ системима може довести до неправедних резултата. Ови резултати могу утицати на појединце у различитим областима, од здравствене заштите, сајбер безбедности и е-трговине до избора, запошљавања и још много тога. То може довести до дискриминације на основу пола, расе, демографије, сексуалне оријентације и других аспеката.

Стога је важно смањити предрасуде у алгоритмима АИ и МЛ како би се промовисала правичност резултата. Горе наведене информације ће вам помоћи да откријете предрасуде и смањите их како бисте могли да креирате поштене АИ системе за кориснике.

Такође можете читати о управљању вештачком интелигенцијом.